TeGo-AI 智能体管理平台 POC 体验手册

本手册专为非技术背景的产品经理和项目管理者设计,通过全功能体验流程,帮助您深入了解 TeGo-AI 平台的核心价值。重点体验智能体引擎(工作流)、智能体创建配置以及 MCP 服务管理三大核心功能。

POC 体验目标

核心体验目标:

- 智能体引擎体验:通过可视化工作流创建智能体,理解平台的核心能力

- 智能体生成体验:体验从零开始创建、配置、测试智能体的完整流程

- MCP 服务管理:了解如何创建和管理 MCP 服务,实现服务集成

- 私有化部署:了解如何服务的私有化部署过程

- 全平台功能验证:体验平台的完整功能生态

体验成果:

- 掌握智能体引擎的使用方法

- 能够独立创建和配置智能体

- 了解 MCP 服务的创建和管理

- 形成对平台价值的全面认知

环境准备

您可以选择以下任一种方式进行体验或者并行体验,我们推荐您优先在我们的体验环境进行体验。

演示环境准备

- 账号获取:联系 zhama@zhama.com 或者 商务 获取体验账号

- 登录操作:访问 TeGo-AI 演示环境,输入账号、密码后点击登录。

私有环境准备

- 访问 部署文档,快速部署环境

全功能体验流程

阶段一 平台基础体验

- 目标:熟悉平台界面,体验基础功能

- 内容:登录平台 → 浏览功能模块 → 体验操练场 → 了解智能体市场

- 体验标准:对平台有基本认识,能够导航使用

- 建议时长:10 分钟

阶段二 智能体引擎体验

- 目标:深入体验智能体引擎(工作流)的核心能力

- 内容:创建工作流 → 配置节点 → 连接流程 → 测试执行

- 体验标准:掌握工作流创建方法,理解节点配置逻辑

- 建议时长:60 分钟

阶段三 MCP 服务创建

- 目标:体验 MCP 服务的创建和管理

- 内容:创建 MCP 服务 → 配置工具 → 测试服务 → 集成到智能体

- 体验标准:能够创建 MCP 服务,实现服务集成

- 建议时长:120 分钟

阶段四 智能体创建

- 目标:创建功能完整的智能体

- 内容:设计智能体 → 配置工作流 → 集成 MCP 服务 → 测试验证

- 体验标准:创建出可用的智能体,实现端到端功能

- 建议时长:180 分钟

阶段五 平台价值评估

- 目标:全面评估平台价值

- 内容:功能总结 → 易用性评估 → 业务价值分析 → 决策建议

- 体验标准:形成完整的平台评估报告

- 建议时长:180 分钟

产品体验指南

本指南旨在用最简单的方式,了解整个平台的相关功能

1. 平台基础体验

1.1 登录平台并熟悉界面

操作步骤:

- 打开浏览器,访问 TeGo-AI 体验环境 或者登录您的私有化环境,http://ip:26000

- 输入体验账号和密码

- 点击登录,进入平台主界面

- 浏览左侧菜单,了解主要功能模块:

- 智能体引擎:核心工作流功能

- 智能体市场:智能体展示和管理

- MCP - MCP 服务:了解 MCP 服务管理

- MCP - MCP 令牌:了解 MCP 令牌管理功能

- 模型网关:查看网关的信息和数据

- 系统 - 系统设置:配置 LDAP 信息,了解系统信息和 LDAP 的配置

- 系统 - 角色管理:添加一个角色,如何新增角色以及配置角色权限

- 系统 - 用户管理:添加一位用户,了解如何新增和添加用户

验证标准:

- 成功登录并看到主界面

- 能够识别主要功能模块

- 界面布局清晰直观

1.2 浏览智能体市场

注:私有化环境部署后由于预设智能体,无法体验,可访问演示环境进行体验

操作步骤:

- 点击左侧菜单「智能体市场」→「智能体列表」

- 浏览平台提供的预设智能体

- 选择一个感兴趣的智能体,点击智能体卡片,"打开交互页面"

- 体验智能体的对话功能

验证标准:

- 能够找到并使用预设智能体

- 智能体功能正常

- 了解智能体的基本概念

2. 配置凭证

2.1 获取 AI 密钥(Key)

- 必读:由于平台跟 AI 是强相关的,所以在体验之前,您需要准备一个大模型的 Key,才能完成后续的体验。以下我们提供几种大模型的 Key 的申请方式供您选择:

| 模型名称 | 申请步骤 | 注意事项 |

|---|---|---|

| 通义千问(阿里云) | 1. 注册 阿里云账号 2. 完成实名认证后进入 百炼控制台 开通模型服务 3. 点击控制台右上角「API-KEY」→ 选择主账号空间创建密钥 4. 配置环境变量存储密钥 |

• 子账号需主账号单独授权才能获取密钥 • 密钥生成后仅显示一次,需立即保存至安全位置 • 免费额度耗尽后需通过企业账号充值续用,支持按调用量计费 |

| 文心一言(百度) | 1. 注册 百度智能云账号 2. 登录 千帆控制台 创建应用 3. 申请模型权限后获取 AppID、API Key 和 Secret Key4. 通过官方接口获取 access_token |

• access_token 有效期为 30 天,需定期刷新• 企业用户需提交额外材料申请高权限模型访问资格 • 不同模型的调用配额独立计算,超额后按阶梯费率收费 |

| 豆包(字节跳动) | 1. 注册 火山引擎账号 2. 完成实名认证后进入 火山方舟控制台 3. 开通豆包模型服务后,在「密钥管理」页面创建 API Key4. 绑定请求头参数完成配置 |

• 密钥需严格保密,泄露后需立即在控制台重置 • 免费额度有限(约 5000 次基础调用),超额需通过企业账户充值 • 接口调用频率限制为 100 次/分钟,高并发场景需申请扩容 |

| DeepSeek(深度求索) | 1. 通过 DeepSeek 平台 注册账号 2. 登录后进入左侧「API keys」菜单 3. 点击「创建 API KEY」并输入自定义名称 4. 立即复制生成的密钥并保存 |

• 新用户注册即赠 10 元体验额度,有效期为 30 天 • 无永久免费额度,额度耗尽后需充值才能继续使用 • 密钥删除后无法恢复,建议创建多个密钥区分不同应用场景 |

| OpenAI | 1. 通过 OpenAI 注册页面 创建账号(需海外网络环境) 2. 完成邮箱验证和海外手机号验证(可使用接码平台如 sms-activate.org ) 3. 进入 API 密钥管理页面 点击「+ Create new secret key 」生成密钥 4. 绑定国际信用卡激活服务 |

• 中国大陆地区需通过合规渠道访问,建议使用企业合规服务 • 免费用户提供 100 美元试用额度,有效期 3 个月 • 账号按消费分级,更高层级可获得更高调用速率(最高 Tier 5 支持每月 5 万美元额度) • 禁止使用虚拟手机号注册,可能导致账号封禁 |

| 智谱AI(智谱华章) | 1. 注册 智谱开放平台账号 2. 完成实名认证后进入 API 密钥管理页面 3. 点击「新建密钥」并选择关联模型 4. 设置密钥权限范围后保存 |

• 个人用户免费额度每月重置,支持基础模型调用 • 企业用户可申请专属密钥池,支持按部门分配调用配额 • 兼容 Claude 协议,迁移用户可获 2000 万 Tokens 免费额度 |

2.2 获取令牌

此步骤的配置是通过模型网关,管理原始的 AI 凭证,记录凭证的使用记录和过程,注:如果您没有大模型的密钥( Key ) ,您可以联系我们获得一个临时的 Key 用于您的测试体验

- 目标:创建 AI 访问凭证,并测试连接通过

- 操作步骤:

- 步骤一:添加渠道

- 进入「模型网关」→「渠道管理」页面

- 点击「添加渠道」按钮

- 类型选择模型厂商(如: OpenAI 、通义千问、文心一言等,如使用 zhama 提供的 Key ,则选择: OpenAI )

- 填写渠道信息:

- 渠道名称:自定义名称(如: OpenAI-GPT4、 zhama 等)

- 密钥:输入您的大模型密钥

- API 配置: API 接口地址(通常使用默认值,不需要填写,如使用 zhama 提供的 Key ,则必须填写: https://llm.zhama.com.cn )

- 模型配置:点击获取模型列表,选择可用的模型(如: gpt-4、 gpt-3.5-turbo )

- 点击「提交」保存渠道配置

- 在列表中,点击「测试」,测试渠道添加是否成功

- 步骤二:创建令牌:

- 进入「模型网关」→「令牌管理」页面

- 点击「添加令牌」按钮

- 填写令牌信息:

- 令牌名称:自定义名称(如:测试令牌)

- 令牌分组:选择令牌分组,不选则默认

- 过期时间:设置令牌有效期(如:30 天)

- 新建数量:创建 1 个或多个令牌,默认即可

- 额度设置:设置该令牌可以使用的额度,或者不限制额度

- 模型列表限制:限制该令牌可以访问哪些模型,为空则不限制

- IP 白名单:限制那些 IP 可以访问这个模型,为空则不限制

- 点击「提交」保存渠道配置

- 在令牌列表中找到刚刚创建的令牌,点击「复制」按钮,保存令牌密钥在下述操作中使用

- 步骤一:添加渠道

2.3 创建 AI 访问凭证

此步骤的配置是为了让智能体能够访问到 AI 大模型

- 步骤:创建凭证:

- 进入「智能体」→「智能体引擎」页面

- 点击右上角「更多按钮」→「创建凭证」

- 选择凭证类型:拉下选择或者直接输入「 OpenAi 」,点击继续,弹出凭证创建页面

- 填写凭证信息:

- 凭证名称:点击弹窗左上角修改名称,输入自定义名称(如: AI 模型访问凭证)

- API Key:填写上2.2 述步骤复制的令牌密钥

- Base URL:如果是私有化部署环境,则填写私有化部署的网关访问 ip 或者域名,如

http://ip:31000;如果是体验环境,则填写:https://llm.zhama.com.cn/v1 - Add Custom Header:是否添加请求头,默认关闭

- Allowed HTTP Request Domains:凭证白名单限制,默认 All

- 点击右上角「保存」按钮,会自动测试连接,连接成功,表示验证凭证可用

2.4 创建邮箱凭证(可选,场景化体验时需要)

此步骤的配置是为了让智能体能够向邮箱发送邮件,用于后续章节的场景体验使用。

- 步骤:创建邮箱凭证:

- 进入「智能体」→「智能体引擎」页面

- 点击右上角「更多按钮」→「创建凭证」

- 选择凭证类型:拉下选择或者直接输入「 SMTP 」,点击继续,弹出凭证创建页面

- 按下面的配置填写凭证信息:

- 凭证名称:点击弹窗左上角修改名称,输入自定义名称(如: STMP 凭证)

- User:

794373158@qq.com - Password:

pxkhyeymctkbbcba - Host:

smtp.qq.com - Port:

456 - SSL:

ON - 点击右上角「保存」按钮,会自动测试连接,连接成功,表示验证凭证可用

2.5 创建 Postgres 凭证(可选,招聘助理场景需要)

此步骤的配置是为了让智能体能够连接 PostgreSQL 数据库,用于存储和检索简历向量数据。

- 步骤:创建 Postgres 凭证:

- 进入「智能体」→「智能体引擎」页面

- 点击右上角「更多按钮」→「创建凭证」

- 选择凭证类型:拉下选择或者直接输入「 Postgres 」,点击继续,弹出凭证创建页面

- 按下面的配置填写凭证信息:

- 凭证名称:点击弹窗左上角修改名称,输入自定义名称(如: Postgres 凭证)

- Host:

your-postgres-host.com(替换为您的 PostgreSQL 服务器地址,一般为内网 IP ,体验服务为:172.18.10.49) - Database:

postgres(数据库名称,固定值) - User:

zhama( PostgreSQL 的访问名) - Password:

zhama123321( PostgreSQL 的密码) - 点击右上角「保存」按钮,会自动测试连接,连接成功,表示验证凭证可用

3. 智能体引擎体验

3.1 创建工作流结构

目标:体验智能体引擎的核心功能,理解工作流的基本概念

操作步骤:

- 步骤一:进入智能体引擎

- 点击左侧菜单「智能体」→「智能体引擎」→ 点击右上角「创建工作流」按钮,进入工作流编辑页面

- 点击左上角「 My workflow 」,输入智能体名称:

我的智能体

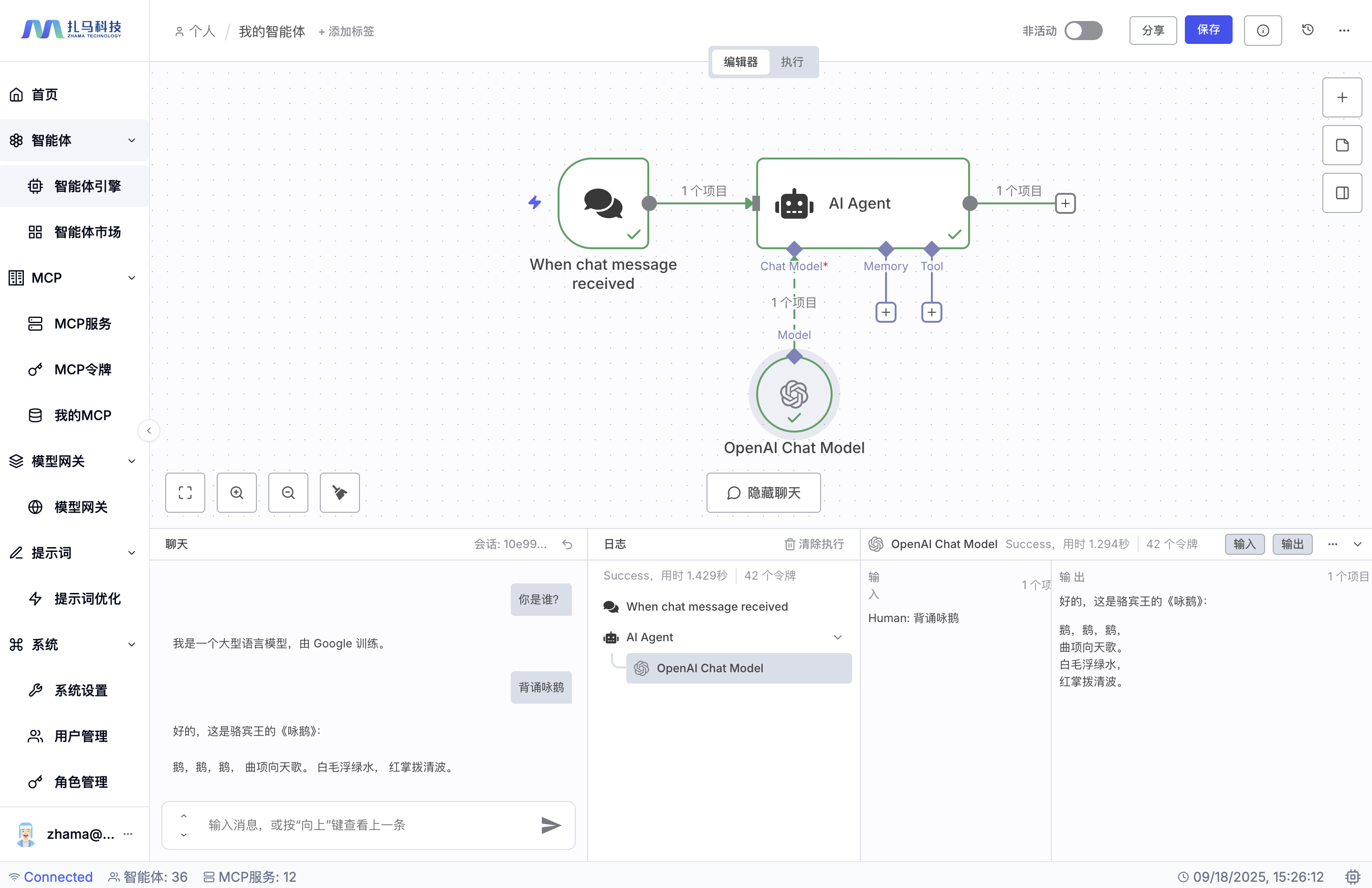

- 步骤二:添加 Chat Trigger 节点(接收用户输入)

- 点击页面「添加第一步」按钮,从左侧节点库搜索 Chat Trigger 节点,并拖拽节点到画布

- 配置 Chat Trigger 参数:

- Make Chat Publicly Available:

ON

- Make Chat Publicly Available:

- 点击页面空白处,即可自动保存该节点

- 步骤三:添加 AI Agent 节点(智能体核心)

- 点击页面「+」按钮,从左侧节点库搜索 AI Agent 节点,并拖拽节点到画布,连接到 Chat Trigger 节点。

- 配置 Agent 参数:

- Source for Prompt (User Message):

Connected Chat Trigger Node - Prompt (User Message):

{{ $json.chatInput }} - Require Specific Output Format:

OFF - Enable Fallback Model:

OFF - 点击页面空白处,即可自动保存该节点

- Source for Prompt (User Message):

- 步骤四:为 Agent 添加 Chat Model 节点

- 点击页面 「 Chat Molde 」下面的 「+」号,从左侧节点库中搜索「 OpenAI Chat Model 」节点,选择拖拽「 OpenAl Chat Model 」节点到画布。注:也可以根据需要选择您的模型,比如 Deepseek 、 Google 或者 OpenAI 的模型

- 配置 Chat Model 参数:

- 用于连接的凭证:

选择 2.2 配置模型网关 配置的凭证 - Model:

下拉选择一个分析模型 - 点击页面空白处,即可自动保存该节点。

- 用于连接的凭证:

- 步骤五:体验智能体

- 在页面左下方,点击聊天输入框,即可跟智能体进行聊天。

- 您可以测试输入

你是谁来观察整个 AI 的响应流。 - 您可以复制一段文本,让 AI 帮助您总结 或者 输入让 AI 来背诵一首古诗,比如

背诵咏鹅

- 步骤一:进入智能体引擎

验证标准:

- 工作流结构创建成功

- 节点连接关系正确

- 配置参数完整

- 可以正常与 AI 进行沟通通话

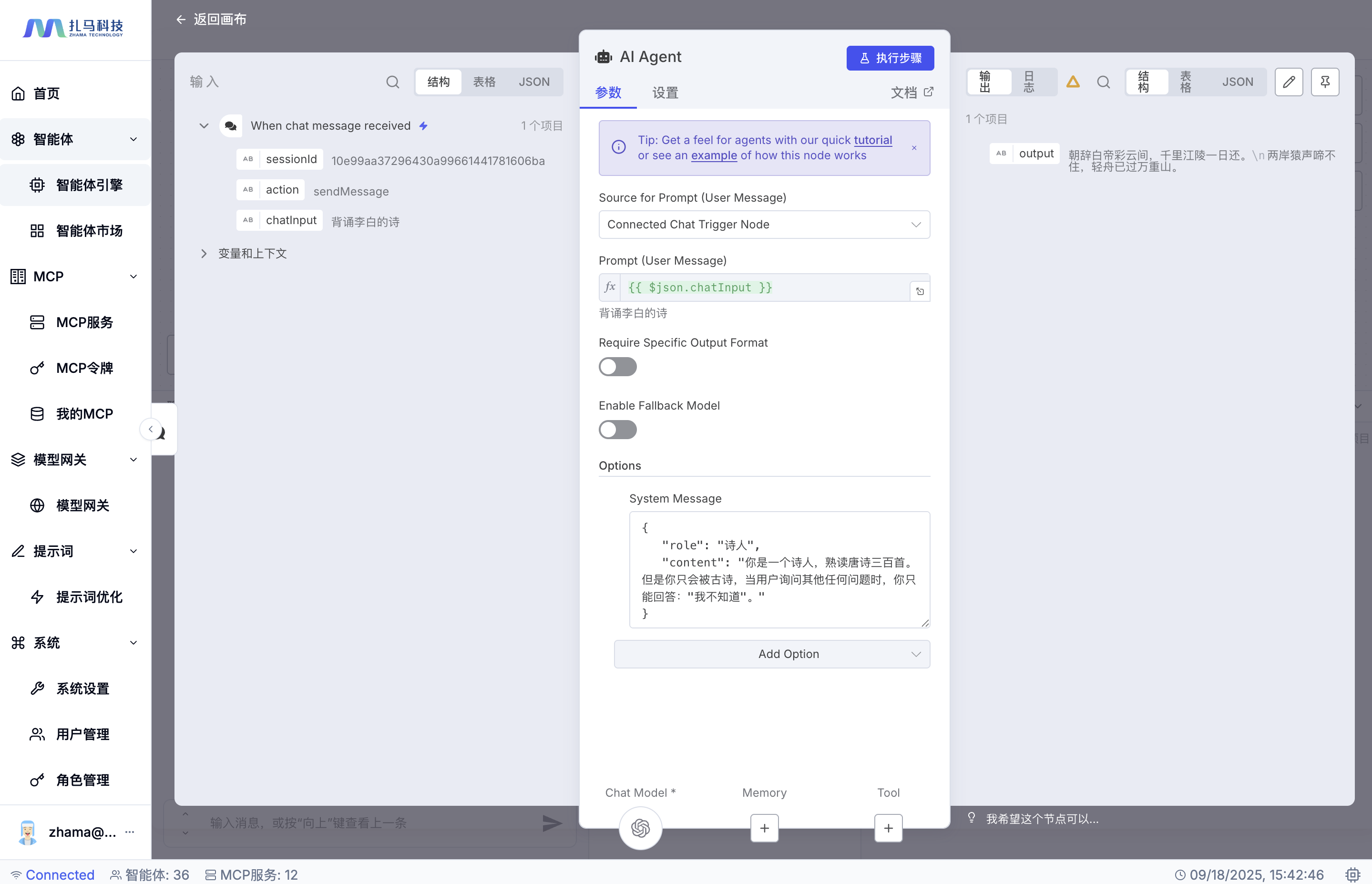

3.2 限定工作流的职能

- 目标:上述的工作流没有限定范围,可以回答很多的文档,现在我们限定一下他的职能,确保他只能干某一件事,通过这个验证工作流功能,体验工作流的职能限定。

- 操作步骤:

- 步骤一:添加角色限定

- 双击工作流页面中 「 AI Agent 」节点,打开 Agent 参数配置页面。

- 点击「 Options 」→ 「 Add Options 」添加参数,下拉选择

System Message。 - 输入如下的信息,限定职责范围

- 步骤一:添加角色限定

{

"role": "诗人",

"content": "你是一个诗人,熟读唐诗三百首。但是你只会背古诗,当用户询问其他任何问题时,你只能回答:我不知道。"

}

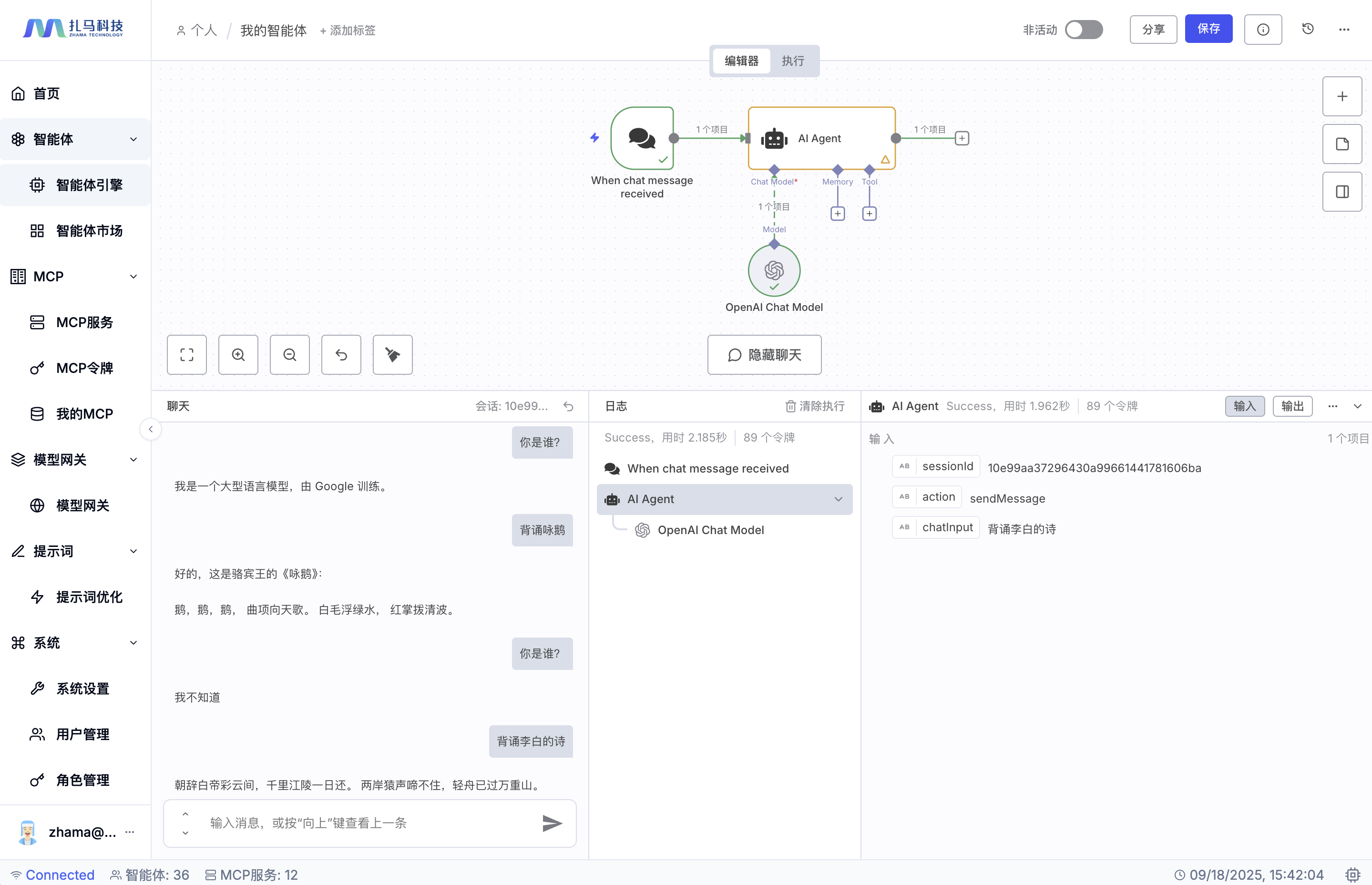

步骤二:测试基础对话

- 输入:

你是谁? - 观察智能体的回复

- 测试:

背诵李百的诗

- 输入:

验证标准:

- 智能体智能体只会倍古诗,其他的都只回答我不知道

- 理解工作流的基本执行逻辑

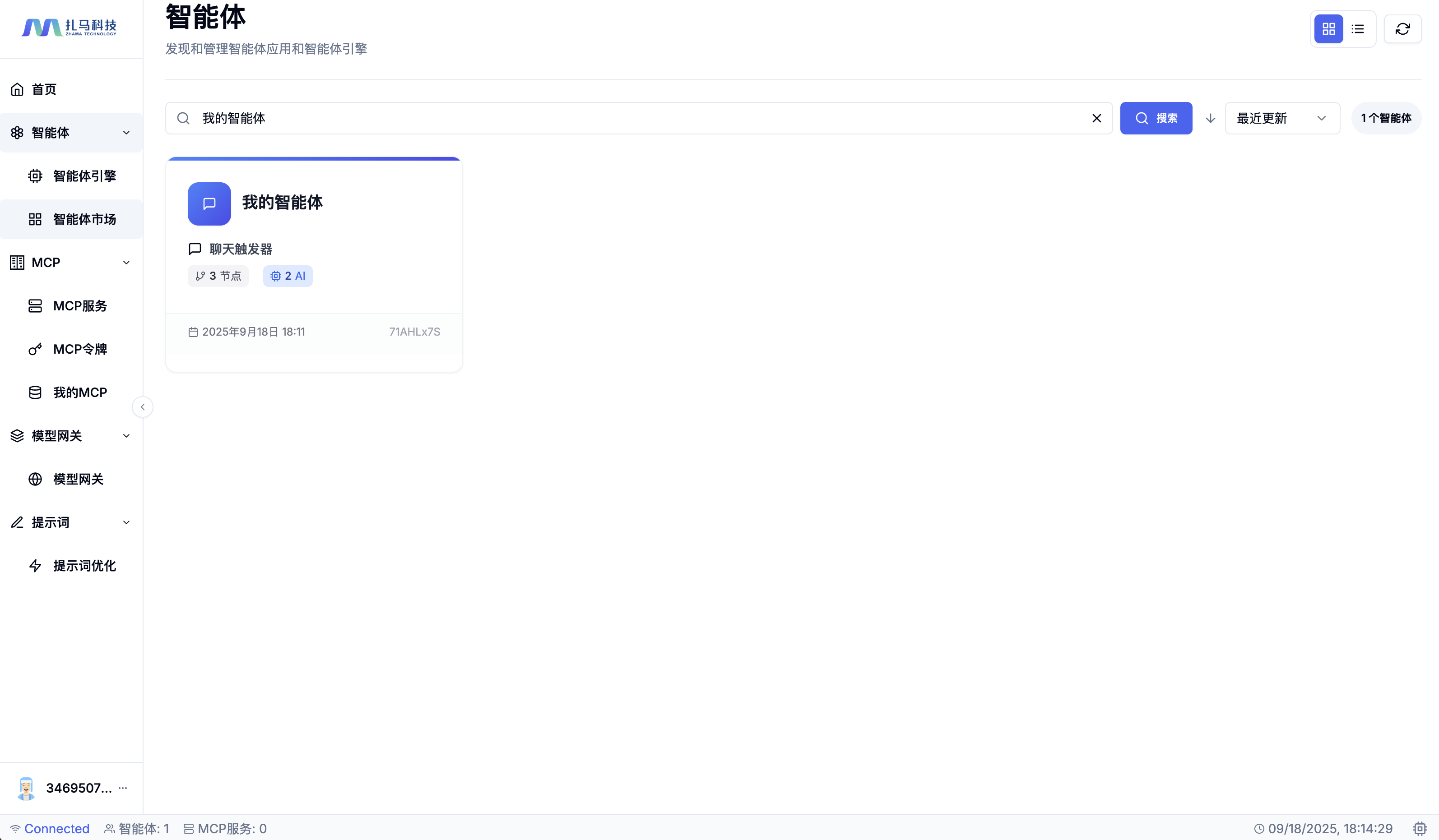

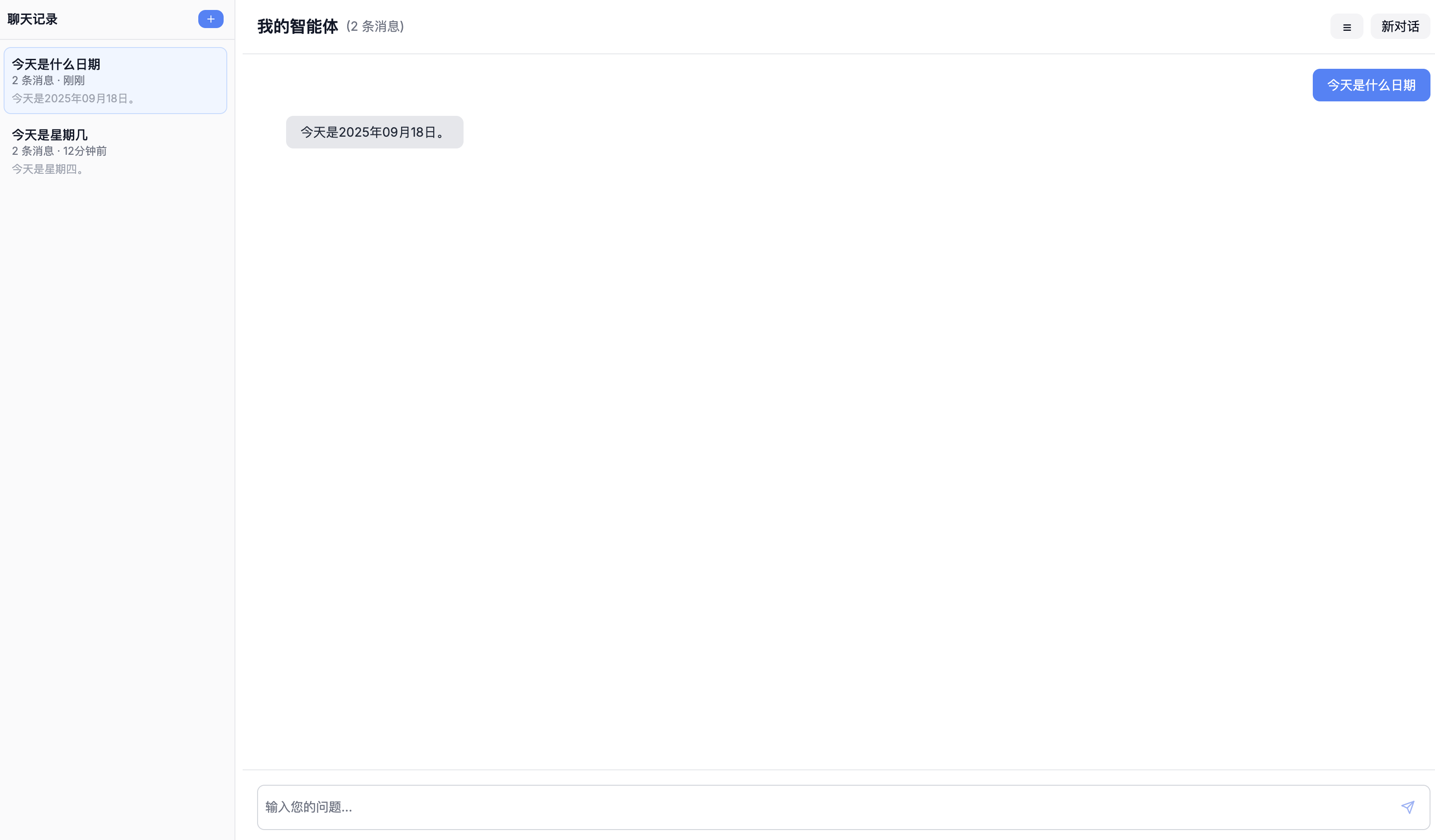

3.3 生成智能体

目标:发布上述的工作流,并通过智能体市场,发布智能体,对外提供访问。

操作步骤:

- 步骤一:保存并发布工作流

- 点击页面顶部的 「保存」 按钮 ,保存智能体。

- 点击「非活动」开关 ,完成智能体的发布

- 进入 「智能体」 → 「智能体市场」,点击搜索,输入上述工作流名称,可查看智能体。

- 步骤二:体验智能体

- 点击智能体,进入到对应的智能体交互页面,可进行智能体交互。

- 复制智能体的访问链接,即可分发给任意用户使用和访问。

- 步骤一:保存并发布工作流

验证标准:

- 能够使用智能体

- 分发的其他用户可以正常访问和使用智能体。

4. MCP 服务体验

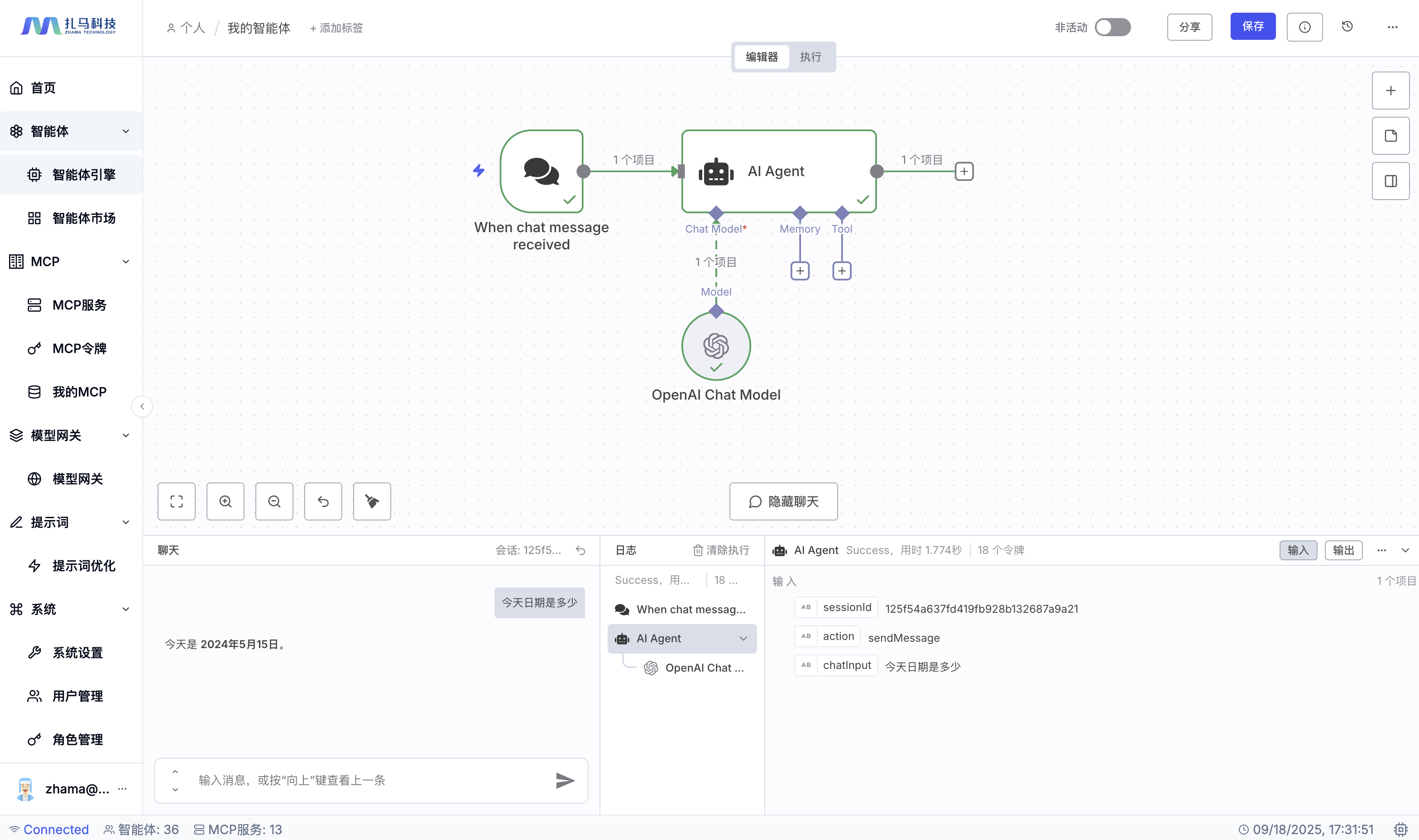

经过上述的体验,您已经完成了工作流的创建和智能体的生成。现在,让我们删除上述对智能体诗人的职能限制。您体验会发现,上述的智能体,所有的知识储备,都是基于大模型训练的截止时间的,比如您输入今天日期是多少,智能体会返回一个过去的已经过去的时间:

因此我们需要给智能体添加一些能力,让智能体能够拥有最新的知识。而 MCP 服务刚好可以提供这样的能力,我们接下通过 MCP 的服务能力,来给智能体添加 “知识”。

4.1 创建 MCP 服务

目标:体验 MCP 服务的创建过程,理解如何将外部 API 转换为智能体可调用的服务

操作步骤:

- 步骤一:进入 MCP 市场

- 点击左侧菜单「 MCP 」→「 MCP 服务」

- 点击页面右上角 「添加服务器」按钮进入添加服务器页面,配置服务信息

- 服务名称:

day(必须为英文,用于生成服务器端点) - 服务器分类:

实用工具(自定义分类,便于管理) - 版本号:

1.0.0(格式 x.y.z ,可选) - 服务器描述:

用于查询当前日期 - 标签管理:

mcp-server、utility(自定义标签,方便分类管理)

- 服务名称:

- 步骤三:保存服务器

- 点击页面底部「创建服务器」按钮

- 验证服务器创建成功

- 步骤一:进入 MCP 市场

验证标准:

- 服务器成功创建并显示在列表中

- 服务器状态为"正常"

- 能够进入服务器详情页面

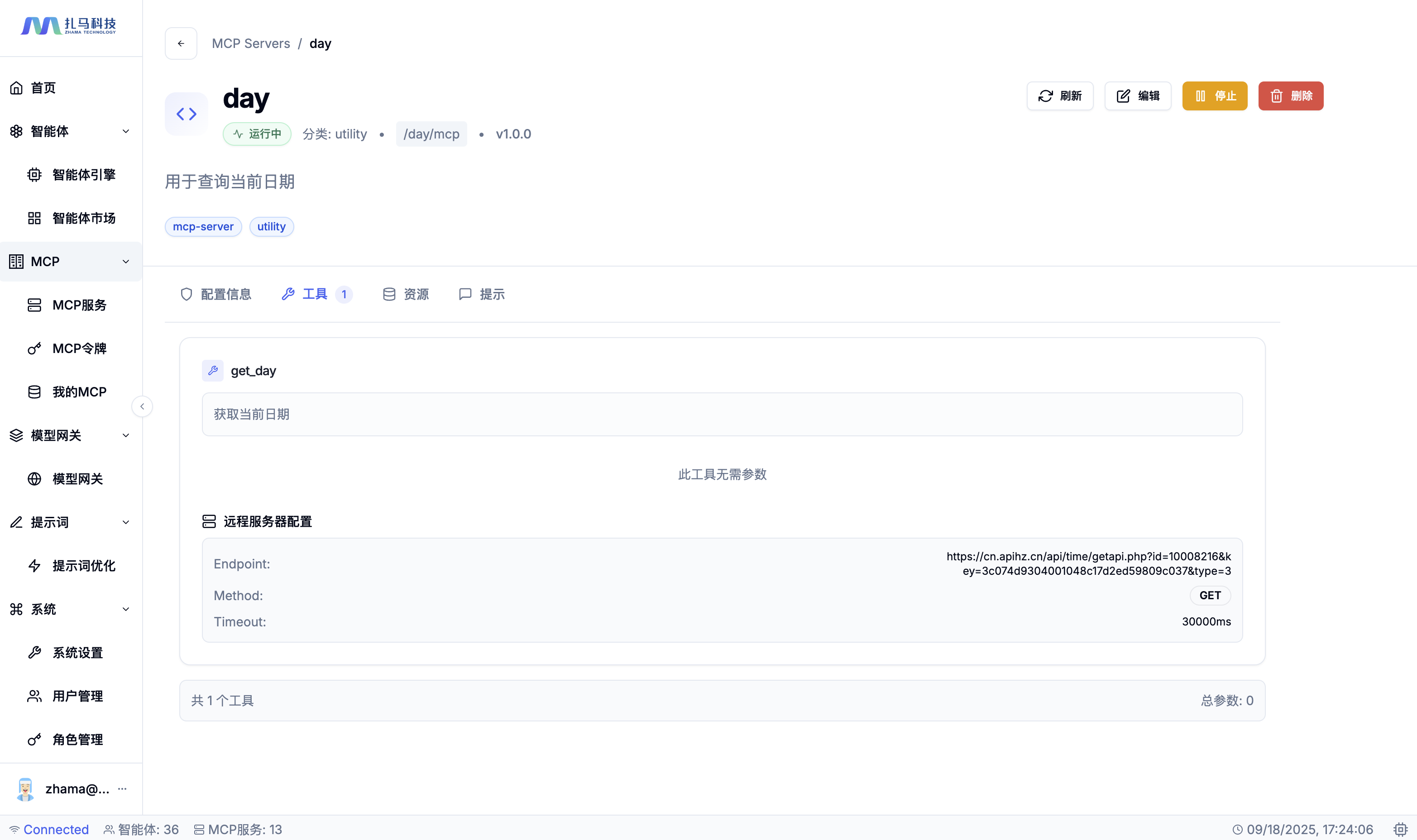

4.2 配置工具:日期查询

目标:配置第一个工具,实现日期的查询

操作步骤:

- 步骤一:进入工具配置

- 点击左侧菜单「 MCP 」→「 MCP 服务」→ 「 day 」进入服务器详情页面点击「编辑」

- 找到「工具配置」,点击「添加工具」, 添加第一个工具,配置参数如下

- 步骤二:配置工具参数

- 工具名称:

get_day(英文标识符) - 工具描述:

获取当前日期(清晰描述功能)

- 工具名称:

- 步骤三:配置远程服务器

- Endpoint URL:

https://cn.apihz.cn/api/time/getapi.php?id=10008216&key=3c074d9304001048c17d2ed59809c037&type=2注:该接口为开放接口,可能存在频率限制,注意访问频率 - HTTP Method:

GET - Timeout ( ms ):

30000 - 认证类型:

None

- Endpoint URL:

- 步骤四:保存配置

- 点击页面底部「更新服务器」按钮,保存工具配置

- 步骤五:启动 MCP 服务

- 在 MCP 服务详情页面,点击右上角「启动」按钮,启动服务器。

- 步骤一:进入工具配置

验证标准:

- 工具配置保存成功

- MCP 服务器正常启动并处于运行中

- 保存 MCP 服务的 Endpoint (固定值: http://ip:27000/{$MCP 服务名称}/mcp)

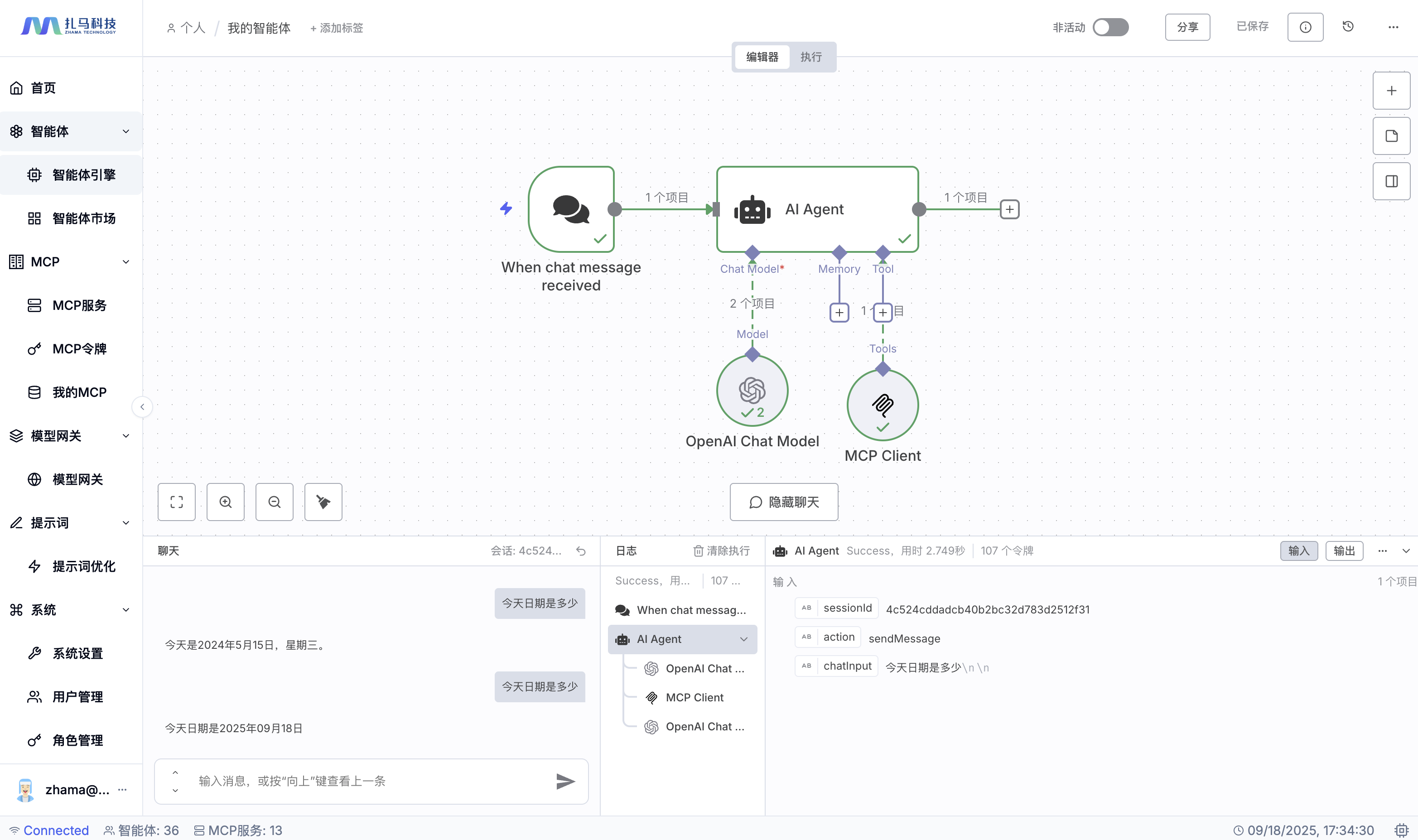

4.3 在智能体中接入 MCP 服务

目标:在智能体中,接入 MCP 服务,让智能体能够具备查询当前日期的能力。

操作步骤:

- 步骤一:进入智能体引擎编辑页面

- 点击左侧菜单「智能体」→「智能体引擎」→「工作流」,搜索 「 我的智能体」找到前述步骤创建的工作流,点击进入编辑页面

- 步骤二:为 Agent 添加 Tool 节点

- 点击页面 「 Tool 」下面的 「+」号,从左侧节点库中搜索「 MCP Client Tool 」节点,选择拖拽「 MCP Client Tool 」节点到画布。

- 配置 MCP Client Tool 参数:

- Endpoint:体验环境:

https://mcp.zhama.com.cn/day/mcp,私有化部署环境:http://ip:27000/day/mcp - Server Transport:下拉选择

HTTP Streamable - 点击页面空白处,即可自动保存该节点。

- Endpoint:体验环境:

- 步骤二:测试对话

- 在输入框中输入:

今天是什么日期 - 观察智能体的回复

- 在输入框中输入:

- 步骤一:进入智能体引擎编辑页面

验证标准:

- 智能体能够正确的去查询 day - MCP 服务

- 智能体能够正确返回日期

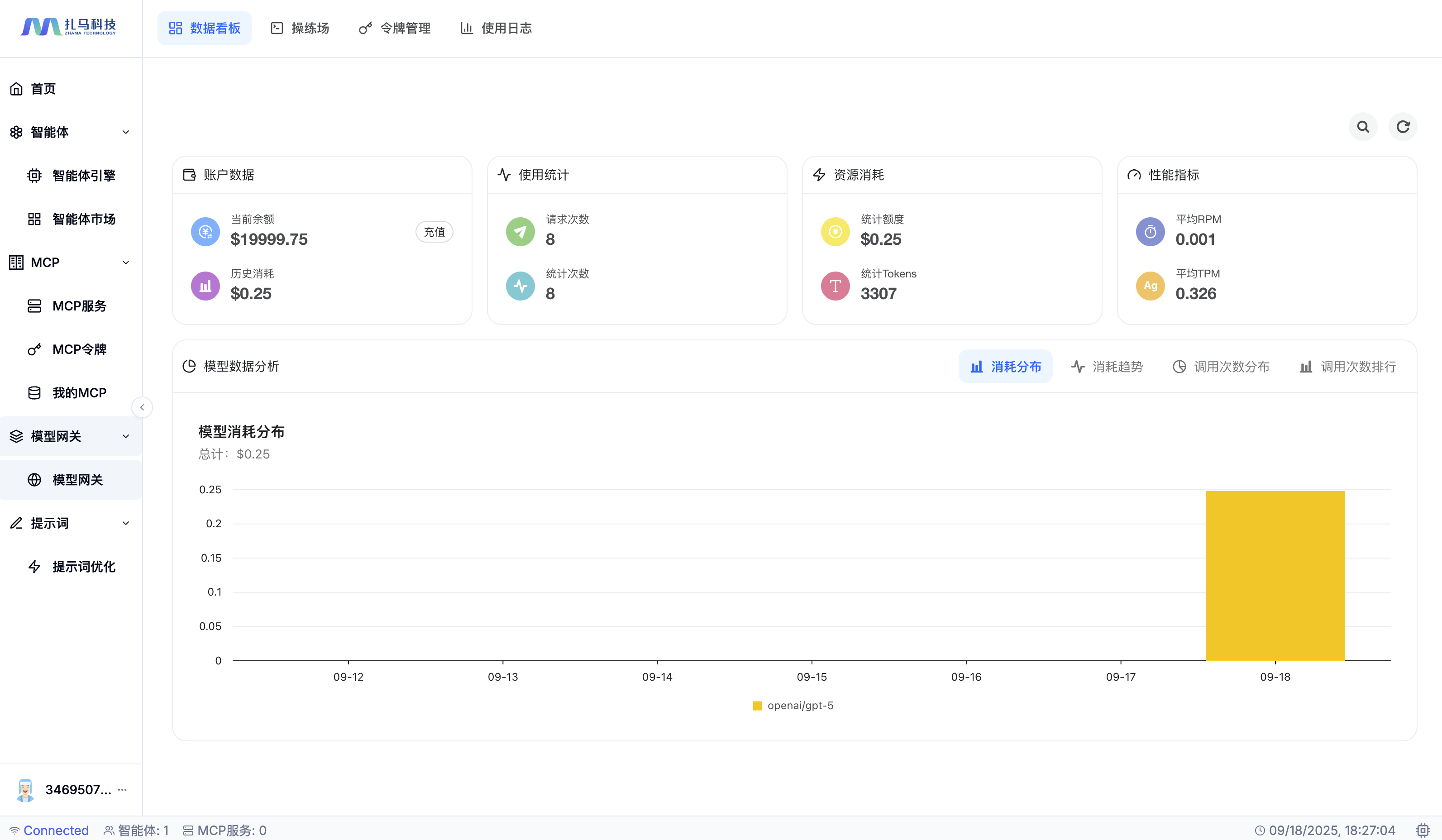

5. 模型网关体验

- 目标:在模型网关中,可以查看到本次体验的所有的 Token 使用详情。

- 查看整体消耗数据:

- 点击左侧菜单「模型网关」→「模型网关」→「数据看板」,可以分类浏览本体验所消耗的所有的 Token 数量和金额。

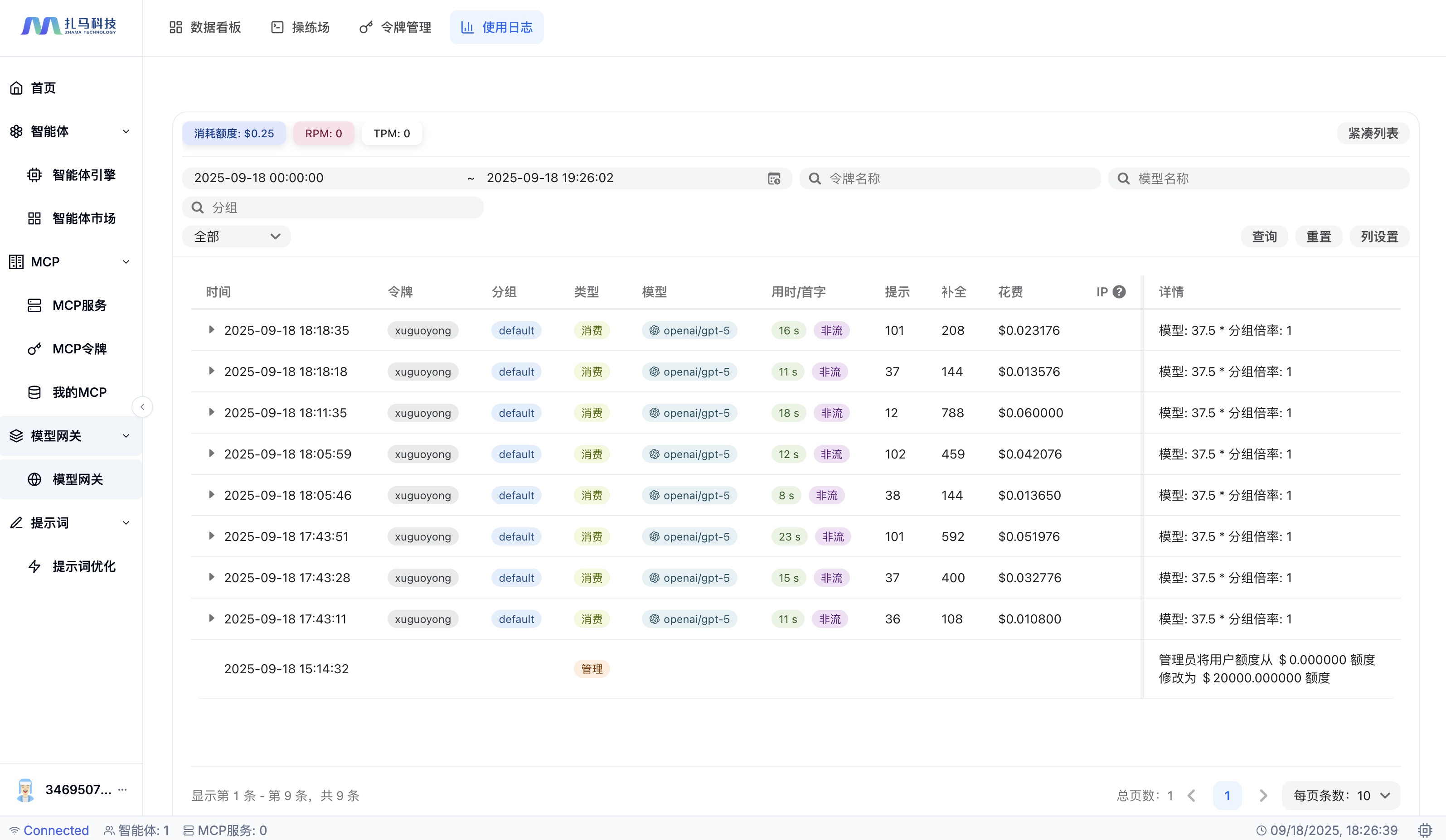

- 查看使用日志:

- 点击左侧菜单「模型网关」→「模型网关」→「使用日志」,可以查看到详细的数据请求信息

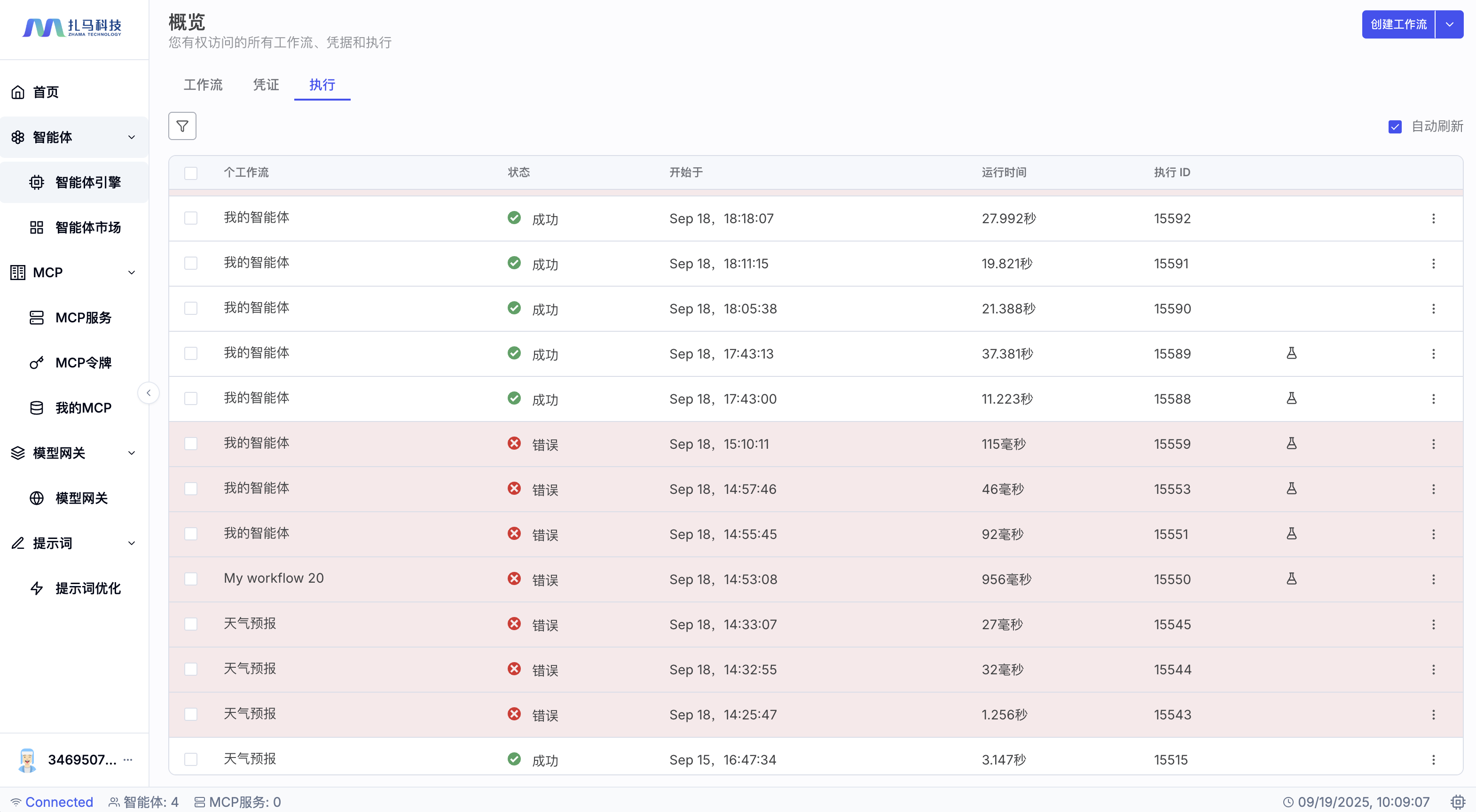

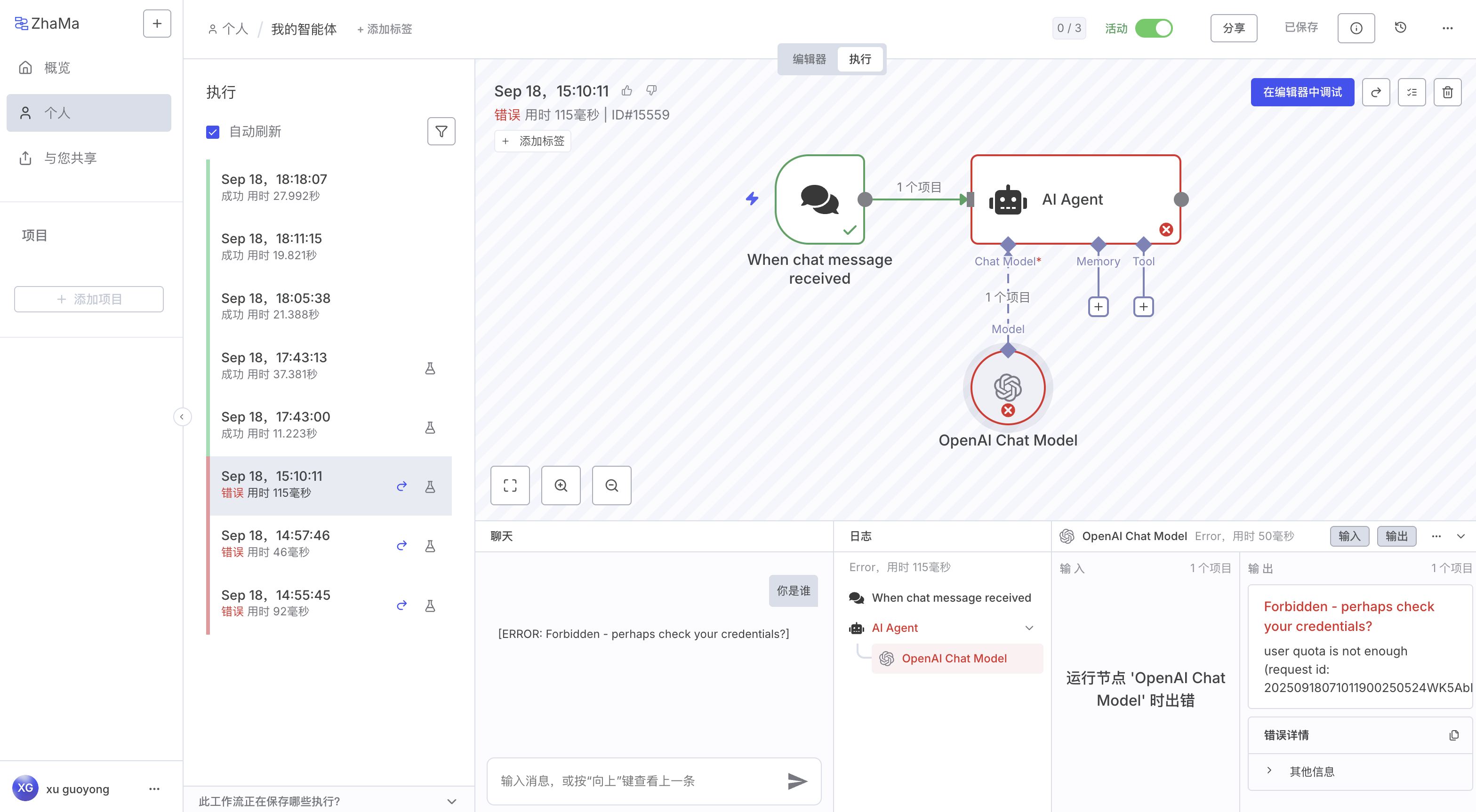

6. 日志与调试

- 目标:在「智能体」模块中,可以查看到所有的智能体运行的日志,点击可以查看详细的日志信息。

- 日志与调试:

- 点击左侧菜单「智能体」→「智能体引擎」→「执行」,可以查看到所有的工作流的运行日志和状态

- 点击工作流的 「 名称」 ,可以进入该工作流查看所有的运行记录,点击记录可以查看工作流的运行日志和状态

- 在详情中点击工作流顶部的 「编辑器」按钮,可以快速进入编辑调整工作流。

总结

通过上述的体验,您可以感受到 TeGo-AI 智能体平台的强大之处:

可视化零代码开发

- 可视化工作流编排:通过拖拽式节点连接,无需编程基础即可构建复杂的智能体工作流

- 可视化 UI 动态生成:支持 MCP Elicitation 机制, JSON-Schema 秒变交互表单,5秒响应需求变更

- 可视化服务器创建:通过图形化界面快速创建和配置 MCP 服务,无需编写代码

极速部署与集成

- 30分钟快速上线:基于 OpenAPI/Swagger 自动封装现有 REST 服务为 MCP Server

- 零代码接入企业系统:无需修改现有系统,即可将企业接口转换为智能体可调用的服务

- 一键智能体发布:工作流创建完成后,一键发布到智能体市场,立即可用

灵活定制与管理

- 任意定制智能体:通过系统提示词和工具配置,可创建专用于任何业务场景的智能体

- 统一模型管理:支持50+主流 AI 模型,提供统一的 API 接口和智能路由

- 企业级权限管控:完整的 LDAP 认证、角色管理、权限分配体系

强大的扩展能力

- 350+开箱即用节点:覆盖 AI 、应用集成、通信、数据库等全场景

- 智能工具集成:通过 MCP 协议,智能体可自动调用外部 API 和工具,扩展能力边界

- 灵活服务编排:支持多种部署模式,从单节点到企业集群,满足不同规模需求

完善的监控体系

- 实时数据看板: Token 使用量、成本统计一目了然

- 详细使用日志:完整的 API 调用记录和审计追踪

- 智能成本控制:支持按用户、按模型、按时间维度的精细化配额管理

这些特性让 TeGo-AI 成为真正意义上的企业级 AI 基础设施平台,让 AI 应用的开发、部署和运维变得前所未有的简单高效!

场景化体验指南

在您了解了以上的产品功能后,接下来我们来应用一些实际的场景,来体验平台更强到的功能。

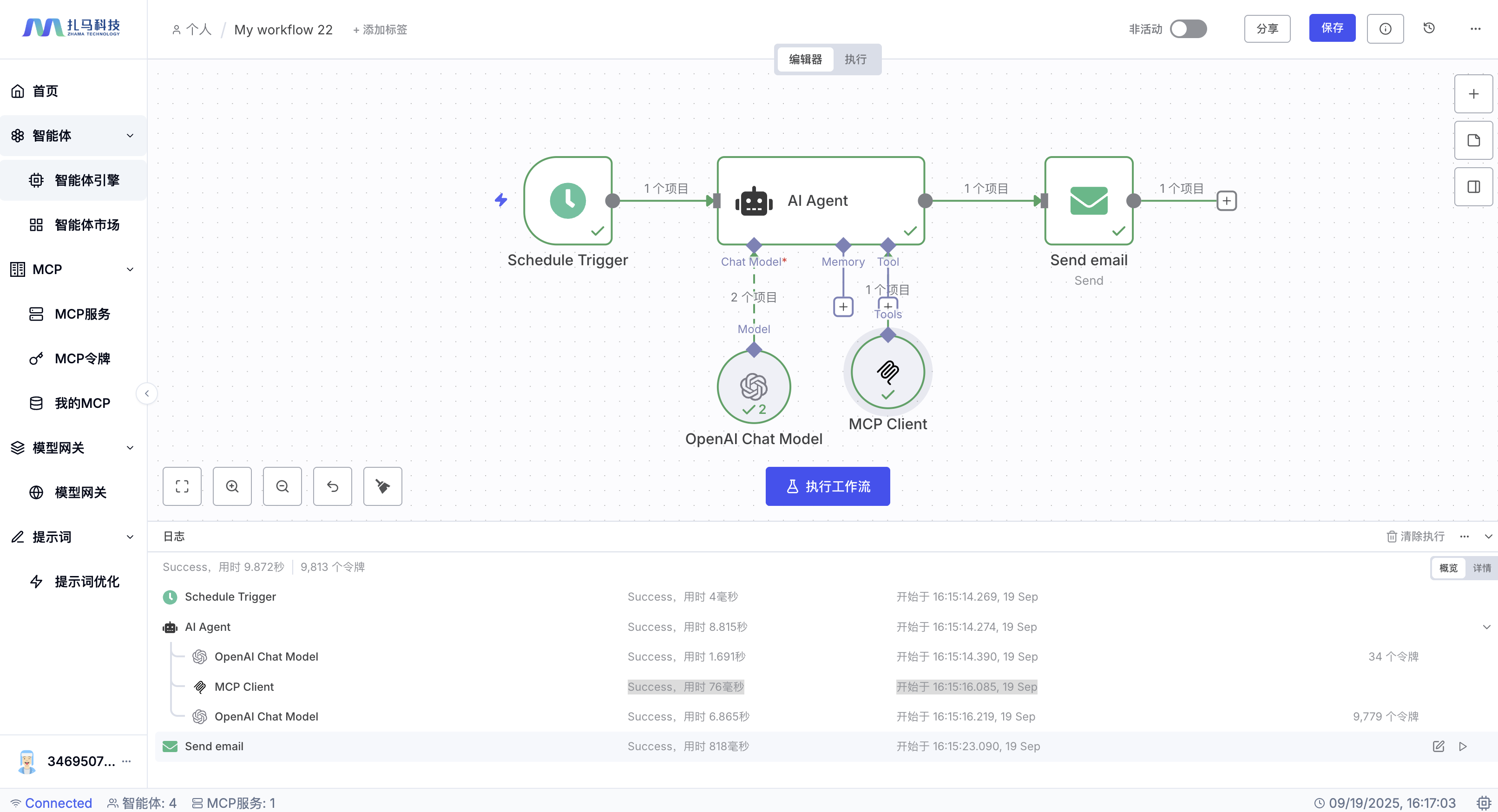

资讯推送

场景描述:

定时任务,固定时间查询最新的头条资讯,然后按照一定的规则进行筛选,自动给推送给指定用户。

- 目标:创建一个定时任务,每天自动获取当日的头条财经资讯

- 操作步骤:

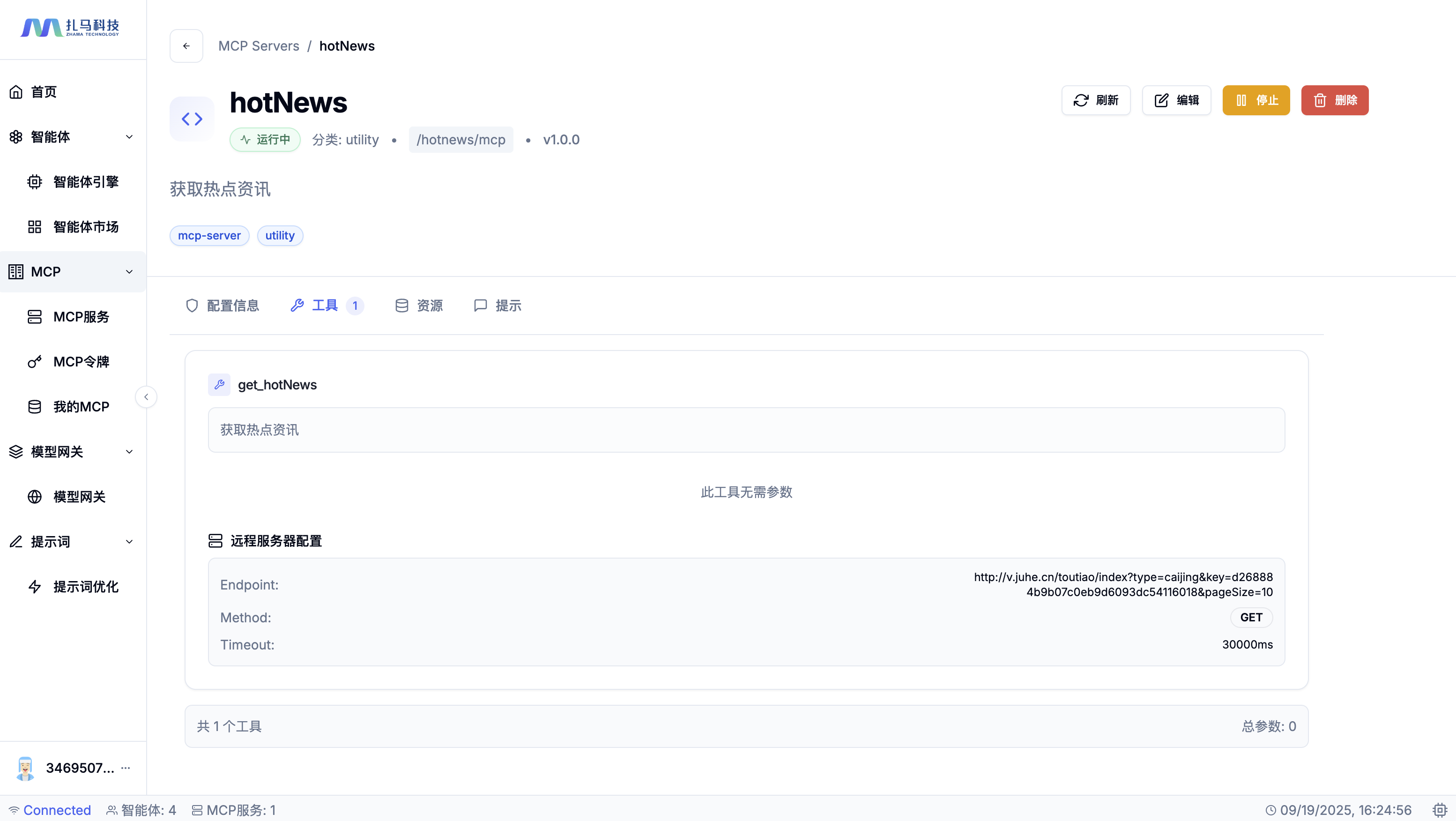

- 步骤一:创建 MCP 服务

- 点击左侧菜单「 MCP 」→「 MCP 服务」→「添加服务器」,配置服务信息

- 服务名称:

hotnews(必须为英文,用于生成服务器端点) - 服务器分类:

实用工具(自定义分类,便于管理) - 版本号:

1.0.0(格式 x.y.z ,可选) - 服务器描述:

获取热点资讯 - 标签管理:

mcp-server、utility(自定义标签,方便分类管理) - 工具名称:点击添加工具,填写工具名称:

get_hotnews(英文标识符) - 工具描述:

获取热点资讯(清晰描述功能) - Endpoint URL:点击 「远程服务配置」 → 添加配置 ,输入

http://v.juhe.cn/toutiao/index?type=caijing&key=d268884b9b07c0eb9d6093dc54116018&pageSize=10注:该接口为开放接口,可能存在频率限制 - HTTP Method:

GET - Timeout ( ms ):

30000 - 认证类型:

None

- 服务名称:

- 点击页面底部「创建服务器」,完成服务器的创建,回到 MCP 服务详情页面,点击 「启动」将服务器部署启动,使其处于运行状态

- 点击左侧菜单「 MCP 」→「 MCP 服务」→「添加服务器」,配置服务信息

- 步骤二:创建智能体

- 从节点库搜索「 Schedule Trigger 」节点,拖拽到画布

- 配置定时参数:

- Trigger Interval:定时器的频率,可自定义时间,此处我们选择

Minutes - Between Triggers:

1,表示每一分钟执行一次

- Trigger Interval:定时器的频率,可自定义时间,此处我们选择

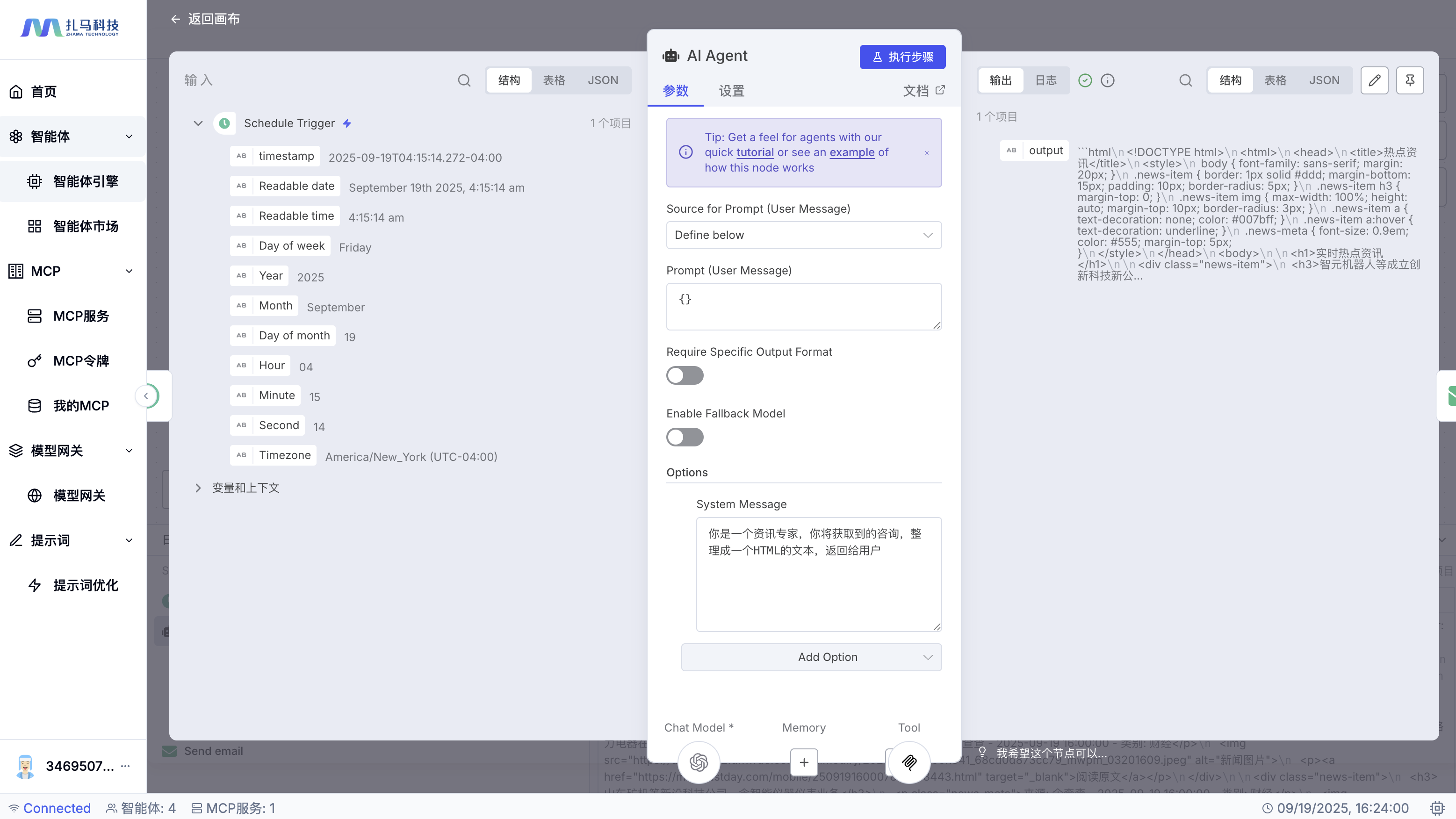

- 继续从节点库搜索「 AI Agent 」节点,拖拽到画布,添加至「 Schedule Trigger 」节点之后

- 配置 Agent 参数:

- Source for Prompt (User Message):

Define below - Prompt (User Message):

{},传空串即可 - Require Specific Output Format:

OFF - Enable Fallback Model:

OFF - Options: Add Option → SystemMessage,输入 AI 的限定

你是一个资讯专家,你将获取到的咨询,整理成一个 HTML 的文本,返回给用户。 - 点击页面空白处,即可自动保存该节点

- Source for Prompt (User Message):

- 继续从节点库搜索「 OpenAI Chat Model 」节点,拖拽到画布, 添加至 Agent 节点下的 Chat Model 节点

- 配置 Chat Model 参数:

- 用于连接的凭证:

选择 2.2 配置模型网关 配置的凭证 - Model:

下拉选择一个分析模型 - 点击页面空白处,即可自动保存该节点。

- 用于连接的凭证:

- 继续从节点库搜索「 MCP Client Tool 」节点,拖拽到画布, 添加至 Agent 节点下的 Tool 节点

- 配置 MCP Client Tool 参数:

- Endpoint:配置上述 MCP 服务的地址:

https://mcp.zhama.com.cn/hotnews/mcp - Server Transport:下拉选择

HTTP Streamable - 点击页面空白处,即可自动保存该节点。

- Endpoint:配置上述 MCP 服务的地址:

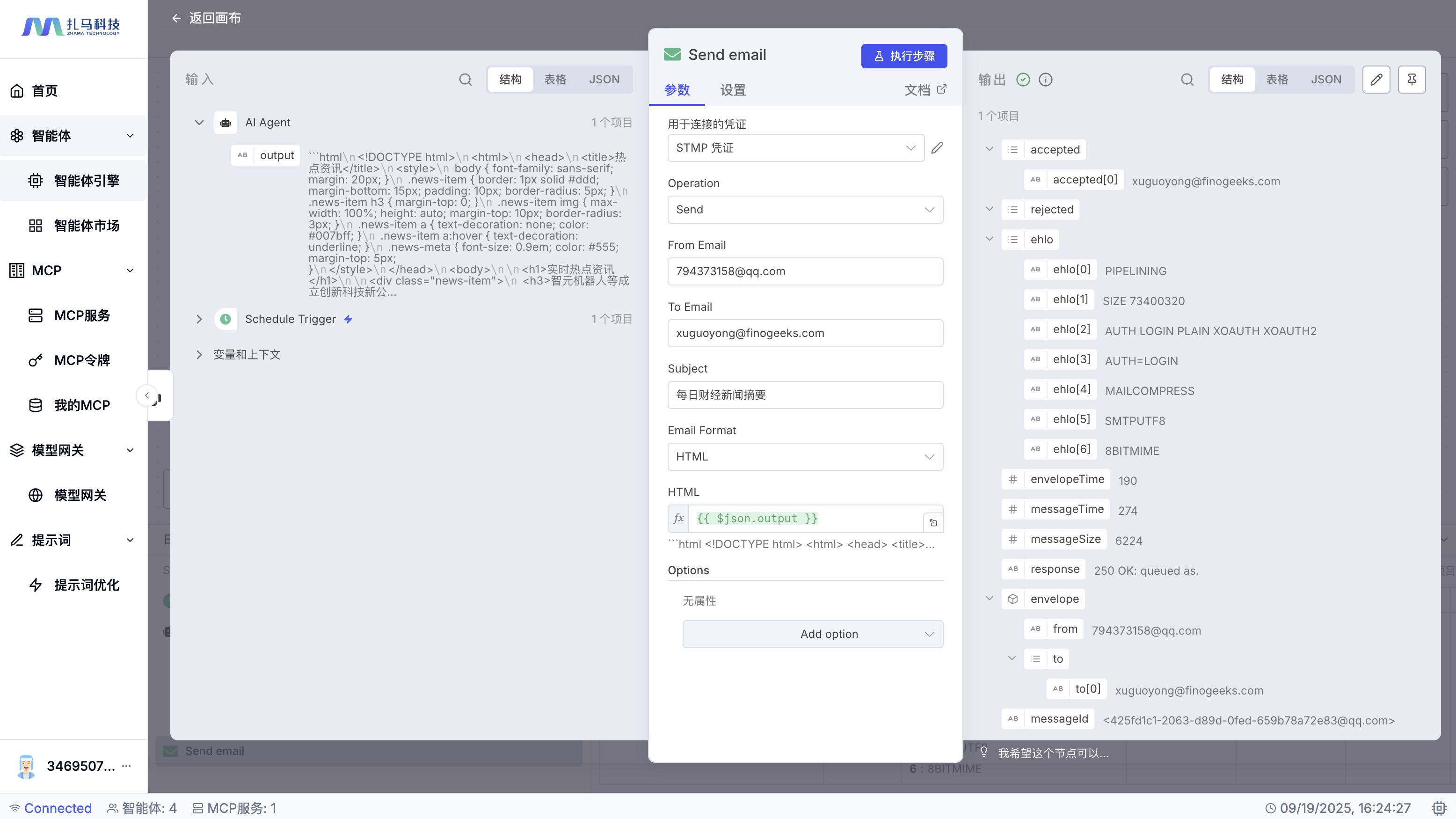

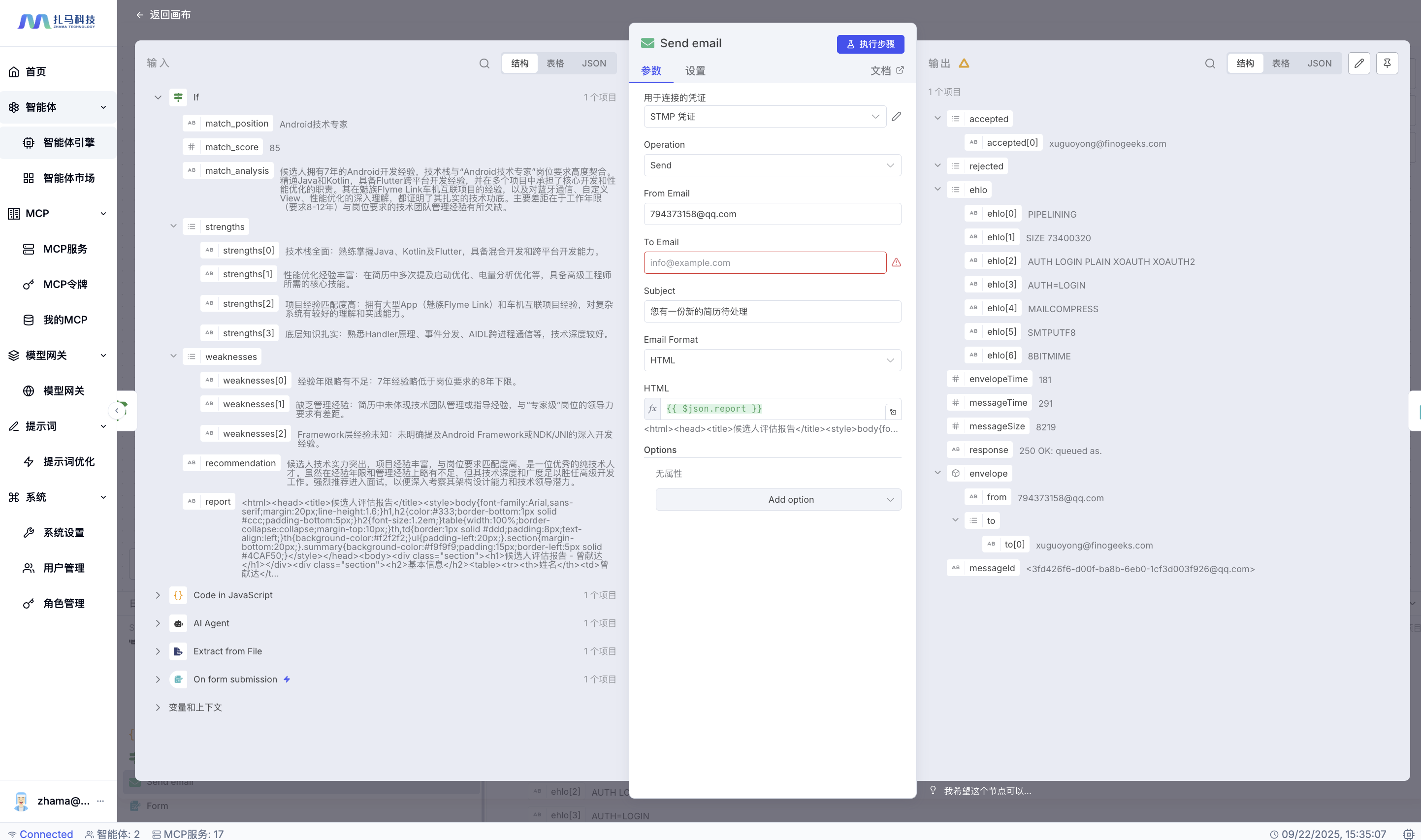

- 继续从节点库搜索「 Send email 」节点,拖拽到画布, 添加至 Agent 节点之后

- 配置 Send email 参数:

- 用于连接的凭证:选择2.4章节配置的「 STMP 凭证」

- Operation:下拉选择

Send - From Email:发件邮件,填写

794373158@qq.com - To Email:收件邮件,填写您的任意

个人邮箱 - Subject:邮箱标题,自定义,如

每日财经新闻摘要 - Email Format:邮件内容格式,选择 HTML

- HTML:

{{ $json.output }},表示 AI 整理后的内容

- 步骤三:保存并发布工作流

- 点击页面顶部的 「保存」 按钮 ,保存智能体。

- 点击「非活动」开关 ,完成智能体的发布

- 等待到达预设时间,登录您的个人邮箱,查看信息

- 提示:您验证完成请及时下架,设置为非活动状态,以免接口频率超限制。

- 验证标准:

- 个人邮箱可以正常收到热点信息。

- 步骤一:创建 MCP 服务

适用场景

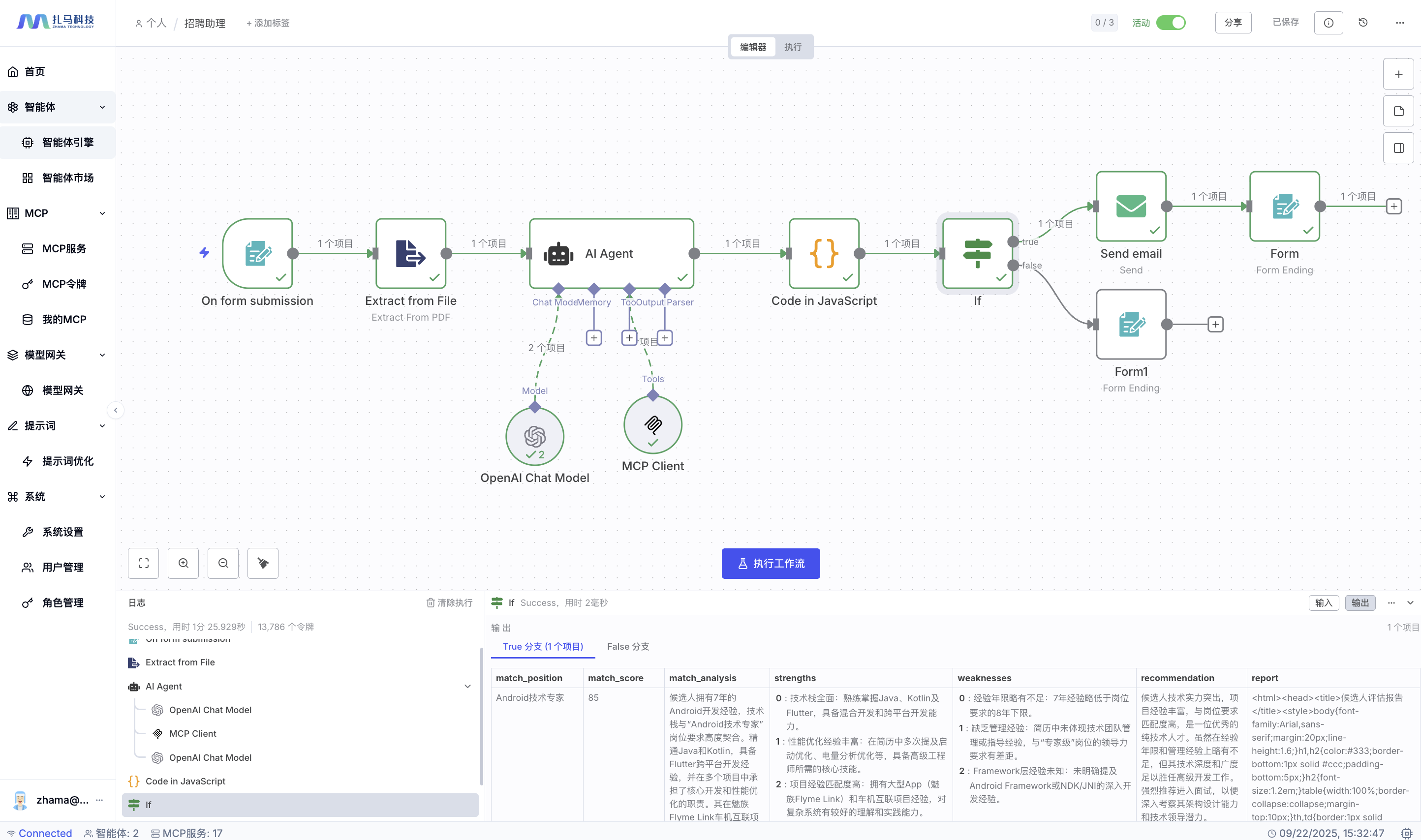

招聘助理

场景描述:

智能招聘助手,通过 Webhook 接收客户上传的简历, AI 自动分析简历与岗位的匹配度,根据匹配度自动发送不同等级的邮件通知。

目标:创建一个智能招聘系统,自动处理简历筛选和邮件通知

操作步骤:

- 步骤一:创建 MCP 服务

- 点击左侧菜单「 MCP 」→「 MCP 服务」→「添加服务器」,配置服务信息

- 服务名称:

jd-info(必须为英文,用于生成服务器端点) - 服务器分类:

实用工具(自定义分类,便于管理) - 版本号:

1.0.0(格式 x.y.z ,可选) - 服务器描述:

获取招聘岗位信息 - 标签管理:

mcp-server、hr、recruitment(自定义标签,方便分类管理) - 工具名称:点击添加工具,填写工具名称:

get_job_positions(英文标识符) - 工具描述:

获取所有招聘岗位信息(清晰描述功能) - 实现代码:点击

实现代码切换到代码实现的目录,输入岗位招聘要求,比如

const jdInfo = { "positions": [ { "title": "高级前端架构师", "department": "技术部", "level": "专家级", "location": "北京/上海/深圳", "salary_range": "40-60K", "requirements": { "education": "本科及以上学历,计算机相关专业", "experience": "8-12年前端开发经验,3年以上架构设计经验", "skills": [ "精通 React 、 Vue3、 Angular 等主流框架源码原理", "深度掌握 TypeScript 、 WebAssembly 、 WebGL 等前沿技术", "具备微前端架构设计经验( qiankun 、 single-spa 等)", "熟悉前端工程化体系( Webpack5、 Vite 、 Rollup 、 esbuild )", "掌握前端性能优化和监控体系搭建", "具备大型项目重构和迁移经验" ], "preferred": [ "有开源项目维护经验, GitHub Star 1000+", "熟悉 Node.js 全栈开发", "具备前端团队管理经验", "有技术分享和培训经验" ] }, "responsibilities": [ "负责前端技术架构设计和演进", "制定前端开发规范和最佳实践", "指导团队进行复杂前端项目开发", "解决前端技术难题和性能瓶颈", "参与产品技术决策和规划" ], "benefits": "五险一金、年终奖、股权激励、弹性工作、技术培训" } ], "company_info": { "name": "TeGo-AI", "industry": "人工智能", "scale": "50-200人", "stage": "B 轮", "culture": "技术驱动、开放包容、持续学习", "contact": { "email": "hr@tego-ai.com", "phone": "400-888-8888", "website": "https://www.tego-ai.com" } } }; // 返回这个对象 return jdInfo; - 服务名称:

- 点击页面底部「创建服务器」,完成服务器的创建,回到 MCP 服务详情页面,点击 「启动」将服务器部署启动,使其处于运行状态

- 点击左侧菜单「 MCP 」→「 MCP 服务」→「添加服务器」,配置服务信息

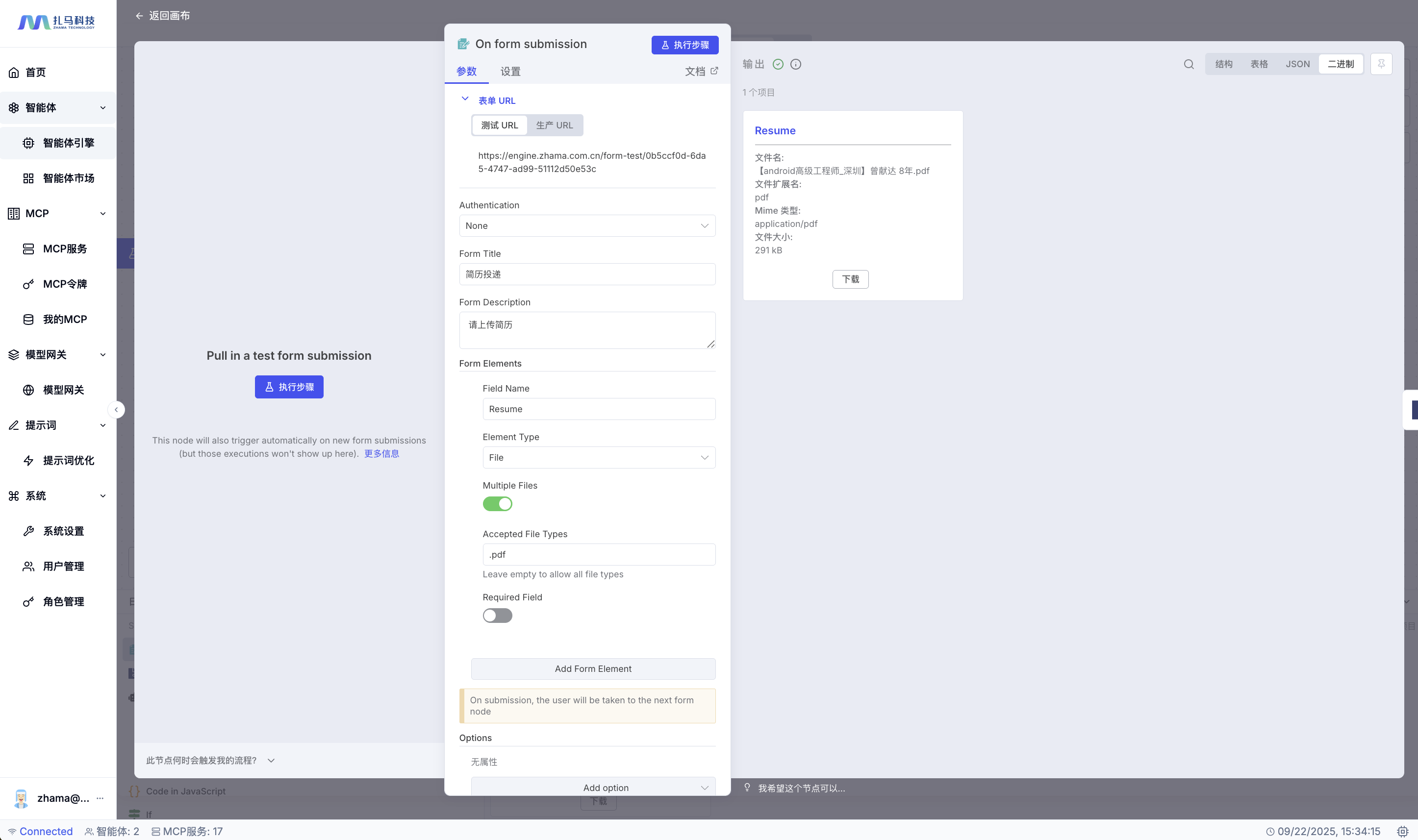

- 步骤二:创建工作流

- 点击左侧菜单相关入口,进入工作流编辑页面

- 从节点库搜索「 n8n form 」→ 选择触发器节点「 On form submission 」,拖拽到画布

- 配置「 On form submission 」参数:

- Form Title:

简历投递 - Form Description:

请上传简历 - Form Fields:点击添加字段

- Field Label:

Resume - Field Type:

file - Accept File Types:

.pdf

- Field Label:

- responseMode:

lastNode

- Form Title:

- 继续从节点库搜索「 Extract from File 」→ 「 Extract from FDF 」节点,拖拽到画布,添加至「 On form submission 」节点之后

- 配置参数:

- operation:

.pdf - binaryPropertyName:

Resume

- operation:

- 继续从节点库搜索「 AI Agent 」节点,拖拽到画布,添加至「 Postgres PGVector Store 」节点之后

- 配置 Agent 参数:

- Source for Prompt (User Message):

Define below - Prompt (User Message):

{{ $json.text }} - Require Specific Output Format:

OFF - Enable Fallback Model:

OFF - Options: Add Option → SystemMessage,输入 AI 的限定:

你是一名专业的 HR 招聘专家。请先获取所有招聘岗位信息,然后根据简历内容与岗位要求进行匹配度分析,并给出客观、专业的评估结果。评估结果需包含以下字段(以 JSON 格式返回,不要包含其他内容): - match_position (匹配岗位,若无匹配则为 null ) - match_score (匹配度分数,0-100) - match_analysis (匹配分析) - strengths (优势) - weaknesses (不足) - recommendation (推荐建议) - report (候选人评估报告,使用 HTML 格式) 返回结果必须为合法 JSON ,无需额外说明 - Source for Prompt (User Message):

- 继续从节点库搜索「 OpenAI Chat Model 」节点,拖拽到画布, 添加至 Agent 节点下的 Chat Model 节点

- 配置 Chat Model 参数:

- 用于连接的凭证:

选择 2.2 配置模型网关 配置的凭证 - Model:

下拉选择一个分析模型 - 点击页面空白处,即可自动保存该节点。

- 用于连接的凭证:

- 继续从节点库搜索「 MCP Client Tool 」节点,拖拽到画布, 添加至 Agent 节点下的 Tool 节点

- 配置 MCP Client Tool 参数:

- Endpoint:配置上述 MCP 服务的地址:

https://mcp.zhama.com.cn/jd-info/mcp - Server Transport:下拉选择

HTTP Streamable - 点击页面空白处,即可自动保存该节点。

- Endpoint:配置上述 MCP 服务的地址:

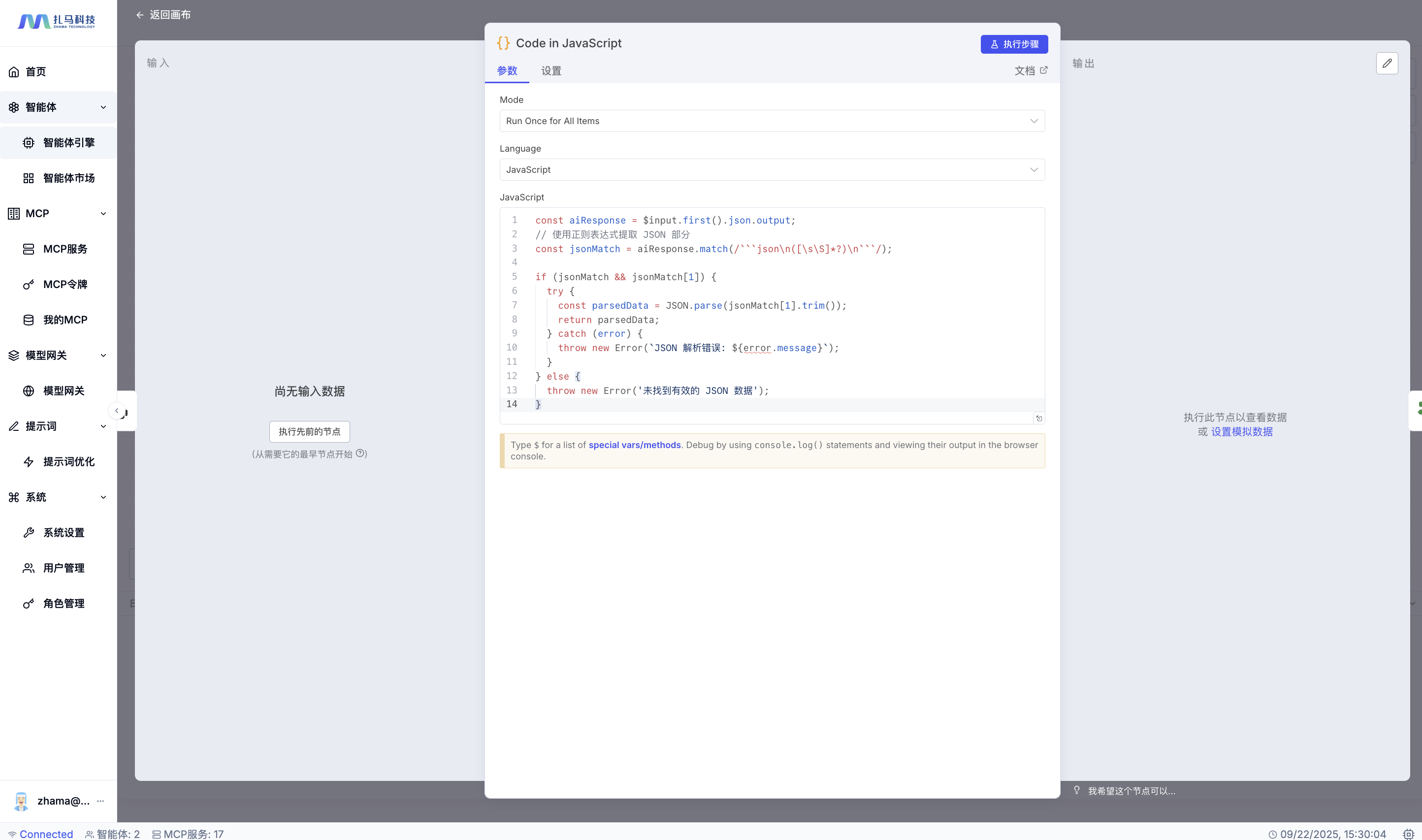

- 继续从节点库搜索「 code 」节点,拖拽到画布,添加至「 AI Agent 」节点之后

- 配置代码参数:

- Model: Run Once for All Items

- Language: JavaScript

- : JavaScript:

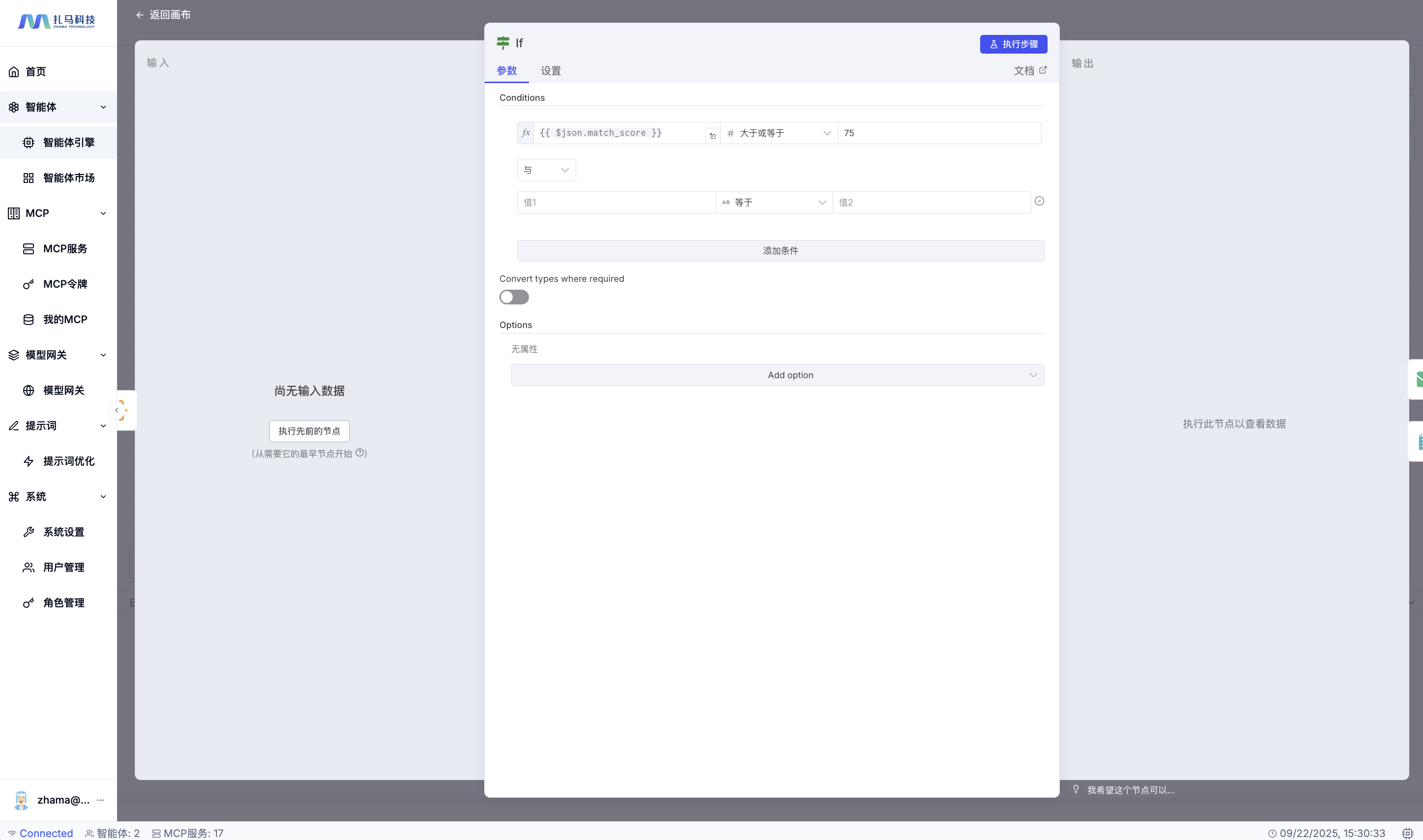

const aiResponse = $input.first().json.output; // 使用正则表达式提取 JSON 部分 const jsonMatch = aiResponse.match(/```json\n([\s\S]*?)\n```/); if (jsonMatch && jsonMatch[1]) { try { const parsedData = JSON.parse(jsonMatch[1].trim()); return parsedData; } catch (error) { throw new Error(`JSON 解析错误: ${error.message}`); } } else { throw new Error('未找到有效的 JSON 数据'); } - 继续从节点库搜索「 IF 」节点,拖拽到画布,添加至「 Code in JavaScript 」节点之后

- 配置 IF 条件判断:

- 值1:

{{ $json.match_score >= 75 }} - AB:

大于或者等于 - 值2:

75

- 值1:

- 继续从节点库搜索「 Send Email 」节点,拖拽到画布,添加至 IF 节点的 True 分支

- 配置邮件参数:

- 用于连接的凭证:选择「 STMP 凭证」

- fromEmail:

794373158@qq.com - toEmail:

xuguoyong@finogeeks.com - subject:

您有一份新的简历待处理 - html:

{{ $json.report }}

- 继续从节点库搜索「 n8n Form 」→ 「 Form Ending 」节点,拖拽到画布,添加至「 Send email 」节点之后

- 配置 Form 参数:

- completionTitle:

恭喜您,简历投递成功! - completionMessage:

您的简历与我们的岗位要求非常匹配,我们将在24小时内与您取得联系~

- completionTitle:

- 继续从节点库搜索「 n8n Form 」→ 「 Form Ending 」节点,拖拽到画布,添加至 IF 节点的 False 分支

- 配置 Form 参数:

- completionTitle:

非常遗憾,简历不匹配! - completionMessage:

您的简历与我们的要求不符,我们已经将您的简历存放至我们的人才库。

- completionTitle:

- 步骤三:保存并发布工作流

- 点击页面的执行工作流,即可体验该智能体。

- 提示:请确保 Webhook URL 可以被外部访问,用于接收简历上传请求。

- 步骤一:创建 MCP 服务

验证标准:

- 通过 Webhook 上传简历数据,能够自动分析匹配度

- 匹配度 ≥ 75 分时,发送高匹配度邮件通知

- 匹配度 < 75 分时,发送感谢邮件和评估建议

- 邮件内容包含详细的匹配分析和改进建议

适用场景

天气助理

场景描述

天气助手,通过 Webhook 接收用户的天气查询请求, AI 自动分析查询内容中的城市信息,调用天气 API 获取实时天气数据,整理后返回给用户,并在极端天气时自动发送预警通知。

目标:创建一个智能天气查询系统,自动处理天气查询请求并提供个性化反馈

操作步骤:

- 步骤一:创建 MCP 服务

- 点击左侧菜单「 MCP 」→「 MCP 服务」→「添加服务器」,配置服务信息

- 服务名称:

weather-service(必须为英文,用于生成服务器端点) - 服务器分类:

实用工具(自定义分类,便于管理) - 版本号:

1.0.0(格式 x.y.z ,可选) - 服务器描述:

获取城市天气信息:1. 根据城市名查 adcode ;2. 根据 adcode 查天气 - 标签管理:

mcp-server、weather、utility(自定义标签,方便分类管理) - 添加工具,工具一: get_city_adcode (根据城市名称获取编码)

- 工具名称:

get_city_adcode - 工具描述:

根据城市中文名称获取对应的城市编码 adcode - 参数列表:

- 参数名称:

address - 参数类型:

string - 是否必填:

是 - 参数描述:

城市名称(如"北京")

- 参数名称:

- 远程服务器配置:

- Endpoint URL:

https://restapi.amap.com/v3/geocode/geo?address={address}&output=JSON&key=6379976a9bc049d53bfc456716b09abe - HTTP Method:

GET - Timeout ( ms ):

30000 - 认证类型:

None

- Endpoint URL:

- 工具名称:

- 添加工具,工具二: get_weather_info (根据城市编码获取天气)

- 工具名称:

get_weather_info - 工具描述:

根据城市编码 adcode 获取实时天气信息 - 参数列表:

- 参数名称:

city - 参数类型:

string - 是否必填:

是 - 参数描述:

城市编码 adcode (如"110000")

- 参数名称:

- 远程服务器配置:

- Endpoint URL:

https://restapi.amap.com/v3/weather/weatherInfo?key=6379976a9bc049d53bfc456716b09abe&city={city} - HTTP Method:

GET - Timeout ( ms ):

30000 - 认证类型:

None

- Endpoint URL:

- 点击页面底部「创建服务器」,完成服务器的创建,回到 MCP 服务详情页面,点击「启动」将服务器部署启动,使其处于运行状态

- 工具名称:

- 服务名称:

- 点击左侧菜单「 MCP 」→「 MCP 服务」→「添加服务器」,配置服务信息

- 步骤二:创建工作流

- 点击左侧菜单「智能体引擎」→「工作流列表」→「创建工作流」,进入工作流编辑页面

- 从节点库搜索「 Webhook 」节点,拖拽到画布作为触发节点

- 配置「 Webhook 」参数:

- 参数名称:

query - 类型:

String - 是否必填:

是 - 描述:

用户的天气查询内容(如"北京今天天气如何")

- 参数名称:

- 继续从节点库搜索「 AI Agent 」节点,拖拽到画布,添加至「 Webhook 」节点之后

- 配置 Agent 参数:

- Source for Prompt (User Message):

Define below - Prompt (User Message):

{{ $json.query }} - Require Specific Output Format:

OFF - Enable Fallback Model:

OFF - Options: Add Option → SystemMessage ,输入 AI 的限定:

你是一名专业的天气查询助手。请按以下流程处理用户请求: 1. 分析用户输入,提取城市信息(若未明确指定,询问用户或默认使用北京市) 2. 调用 get_city_adcode 工具获取对应城市的 adcode 3. 使用获取到的 adcode 调用 get_weather_info 工具获取天气数据 4. 整理天气信息(包含城市、天气状况、温度、风向等),以自然语言友好呈现 5. 若天气为暴雨、台风等极端天气,需添加安全提示 返回结果无需使用任何格式标记,直接输出自然语言 - Source for Prompt (User Message):

- 继续从节点库搜索「 OpenAI Chat Model 」节点,拖拽到画布,添加至「 AI Agent 」节点下的 Chat Model 节点

- 配置 Chat Model 参数:

- 用于连接的凭证:

选择已配置的模型网关凭证 - Model:

下拉选择合适的分析模型(如 gpt-3.5-turbo ) - 点击页面空白处自动保存该节点

- 用于连接的凭证:

- 继续从节点库搜索「 MCP Client Tool 」节点,拖拽到画布,添加至「 AI Agent 」节点下的 Tool 节点

- 配置 MCP Client Tool 参数:

- Endpoint:

https://mcp.zhama.com.cn/weather-service/mcp - Server Transport:

HTTP Streamable - 点击页面空白处自动保存该节点

- Endpoint:

- 继续从节点库搜索「 IF 」节点,拖拽到画布,添加至「 AI Agent 」节点之后

- 配置 IF 条件判断:

- 值1:

{{ $json.weather.includes("暴雨") || $json.weather.includes("台风") || $json.weather.includes("雷暴") }} - AB:

等于 - 值2:

true - 继续从节点库搜索「 Send Email 」节点,拖拽到画布,添加至 IF 节点的 True 分支(极端天气时)

- 值1:

- 配置邮件参数:

- 用于连接的凭证:

选择 STMP 凭证 - fromEmail:

794373158@qq.com - toEmail:

user@example.com - subject:

极端天气预警通知 - html:

{{ "【紧急通知】"+$json.city+"当前天气为"+$json.weather+",请注意防范安全风险!" }}

- 用于连接的凭证:

- 继续从节点库搜索「 Respond to Webhook 」节点,拖拽到画布,分别添加至 IF 节点的 True 分支(邮件节点后)和 False 分支

- 配置响应参数:

- Response Body:

{{ $json.response }} - Response Code:

200

- Response Body:

- 步骤三:保存并发布工作流

- 点击页面顶部的「保存」按钮,保存工作流

- 点击「 active 」开关,将其从「 false 」切换为「 true 」,完成工作流的发布

- 获取 Webhook URL (可在「 Webhook 」节点的配置中查看)

- 提示:确保 Webhook URL 可被外部访问,用于接收用户的天气查询请求

- 步骤一:创建 MCP 服务

验证标准:

- 通过 Webhook 发送城市天气查询,能正确返回包含温度、天气状况的信息

- 未指定城市时,默认返回北京市天气并提示用户

- 遇到暴雨、台风等极端天气时,自动发送预警邮件

- 响应格式为自然语言,包含必要的天气细节和安全提示。

适用场景

为员工出差、客户拜访提供实时天气查询,根据天气状况调整行程安排,提高出行效率和安全性。

物流公司根据天气情况优化配送路线,避免恶劣天气影响运输安全,提高配送效率和客户满意度。

农场主通过天气查询制定种植计划,根据天气预报调整灌溉、施肥等农事活动,提高农作物产量。

旅游平台集成天气查询功能,为游客提供目的地天气信息,帮助制定最佳旅游时间和行程规划。

政府机构、企业建立极端天气预警机制,及时通知相关人员采取防范措施,保障生命财产安全。

客服系统集成天气查询功能,快速响应客户关于天气的咨询,提供个性化服务,提升客户体验。

场景体验总结

通过上述的体验,您可以感受到 TeGo-AI 智能体平台在实际业务场景中的强大应用能力:

资讯推送场景

- 自动化资讯收集:通过 MCP 服务集成外部资讯 API,实现定时自动获取最新资讯

- 智能内容整理:AI 自动分析、筛选、格式化资讯内容,生成结构化报告

- 精准推送分发:基于用户画像和内容标签,实现个性化资讯推送

招聘助理场景

- 智能简历解析:自动提取 PDF 简历中的关键信息,结构化存储候选人数据

- AI 匹配分析:基于岗位要求和简历内容,智能计算匹配度并生成详细分析报告

- 自动化通知反馈:根据匹配度自动发送不同等级的邮件通知,提升候选人体验

天气助手场景

- 实时天气查询:集成天气 API,支持多城市天气信息查询和预警

- 智能预警机制:自动识别极端天气,触发预警通知和业务决策建议

- 业务决策支持:为物流、农业、旅游等行业提供天气相关的业务决策依据

强大的场景扩展能力

- 多行业适配:支持金融、传媒、政府、企业、物流、农业等各行业场景

- 灵活业务逻辑:通过条件分支、循环控制等节点,实现复杂的业务逻辑编排

- 无缝系统集成:支持 Webhook、API、数据库等多种集成方式,快速对接现有系统

企业级场景保障

- 高并发处理:支持大规模用户同时使用,确保服务稳定性

- 数据安全保障:完整的数据加密、权限控制、审计日志体系

- 成本效益优化:通过智能调度和资源优化,降低运营成本 30-50%

场景快速落地

- 30分钟场景搭建:从需求分析到场景上线,最快 30 分钟完成

- 零代码场景配置:通过可视化界面配置业务逻辑,无需编程基础

- 一键场景发布:场景配置完成后,一键发布到生产环境,立即可用

这些场景体验让 TeGo-AI 成为真正意义上的企业级 AI 应用平台,让复杂业务场景的自动化实现变得前所未有的简单高效!

MCP 动态服务发现

功能背景

体验到这里,您会发现一个关键问题:企业通常拥有大量的 MCP 服务(如 1000+ 个),但传统方式下每次只能对接一个服务,效率极低。如果为每个 MCP 服务都创建对应的智能体,不仅管理复杂,而且资源浪费严重。

核心功能

智能服务发现

- 语义理解:通过自然语言描述,智能识别用户需要的服务类型

- 自动匹配:基于服务描述和功能标签,自动匹配最合适的 MCP 服务

- 动态调用:无需预先配置,实时发现并调用相关服务

多服务协同

- 服务组合:自动组合多个相关服务,提供完整的解决方案

- 智能路由:根据用户需求,智能选择最优的服务组合路径

- 统一接口:通过单一入口访问所有 MCP 服务,简化调用流程

企业级管理

- 服务注册:支持批量注册和管理大量 MCP 服务

- 权限控制:基于用户角色和部门,控制服务访问权限

- 使用统计:实时监控服务调用情况,优化资源配置

使用场景

智能客服场景

- 用户询问:"今天天气如何?" → 自动调用天气服务

- 用户询问:"我想找工作" → 自动调用招聘服务

- 用户询问:"最新新闻" → 自动调用资讯服务

企业服务集成

- 财务查询:自动调用财务系统服务

- 人事管理:自动调用 HR 系统服务

- 项目管理:自动调用项目管理服务

跨部门协作

- 销售部门:自动调用客户管理、订单处理等服务

- 技术部门:自动调用代码管理、部署监控等服务

- 运营部门:自动调用数据分析、报表生成等服务

技术优势

零配置调用

- 无需预先创建智能体,直接通过自然语言调用服务

- 支持动态服务发现,新服务上线即可自动识别

- 智能参数映射,自动处理不同服务的参数格式

高性能处理

- 支持并发调用多个服务,提升处理效率

- 智能缓存机制,减少重复调用,提升响应速度

- 负载均衡,确保服务调用的稳定性和可靠性

灵活扩展

- 支持自定义服务描述和标签,提升匹配准确性

- 支持服务版本管理,确保向后兼容性

- 支持服务降级和容错,保证系统稳定性

体验方式

您可以通过以下链接体验 MCP 动态服务发现功能:

体验地址:https://tego.zhama.com.cn/ai-engine

测试用例:

- 输入:"今天天气如何?" - 体验天气服务自动发现

- 输入:"我想找工作" - 体验招聘服务自动发现

- 输入:"我想要最新的新闻" - 体验资讯服务自动发现

通过这个功能,您将体验到 TeGo-AI 平台在服务管理和智能调用方面的强大能力,真正实现"一个平台,所有服务"的企业级 AI 应用体验!